基本介紹

- 中文名:損失函式

- 外文名:loss function

- 類型:函式

- 套用學科:統計學

- 套用領域:機器學習,經濟學,控制理論

函式定義

函式分類

回歸問題

分類問題

名稱 | 表達式 |

|---|---|

鉸鏈損失函式(hinge loss function) |  |

交叉熵損失函式(cross-entropy loss function) |  |

指數損失函式(exponential loss function) |  |

代價函式一般指本詞條

名稱 | 表達式 |

|---|---|

鉸鏈損失函式(hinge loss function) |  |

交叉熵損失函式(cross-entropy loss function) |  |

指數損失函式(exponential loss function) |  |

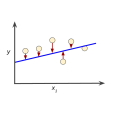

函式 被稱為目標函式,或者代價函式。一個最小化(或者最大化)目標函式的可行解被稱為最優解。 一般情況下,會存在若干個局部的極小值或者極大值。局部極小值 定義為對於一些 ,以及所有的 滿足 公式 成立。 符號表示 播報 編輯 最...

風險函式(Risk function)定義為代價函式的均值,即:△ 貝葉斯估計-使風險函式最小的估計。由於估計誤差 決定估計問題中估計質量的好壞,所以,通常僅對估計值與真實值之差 感興趣。若考慮誤差函式的代價,這時C可定義為(S- )的...

相似性測度( similarity measure)是刻畫或說明匹配實體之間相似性程度的一種定量度量指標。一般說來,相似性程度是通過代價函式來計算的。在基於灰度的影像匹配中,常用的相似性測度包括相關係數測度、差平方和測度及差絕對和測度等。代價...

恆模算法,簡稱CMA算法是Bussgang類盲均衡算法中最常用的一種,就是當參數P=2時的Godard算法。CMA算法具有計算複雜度低,易於實時實現,收斂性能好等優點,代價函式只與接收序列的幅值有關,而與相位無關,故對載波相位不敏感。背景 序...

代價函式是指在一個最最佳化波束形成器中,通過使用代價函式(如均方誤差)最小化來實現方向圖的形成。通常,這個代價函式反比於陣列的輸出。這樣,當代價函式最小時,陣列輸出端的信號質量就達到最優。梯度的計算是複雜的,通常用適當的...

從而獲得各層單元的參考誤差,以便調整相應的連線權。誤差反傳播學習通過一個使代價函式最小化過程完成輸人到輸出的映射。通常代價函式定義為所有輸入模式中輸出單元的希望輸出與實際輸出之差的平方和。

最小均方誤差準則是在統計平均的意義下使濾波器輸出與期望回響之間的誤差的平方最小,在平穩的環境下所得的濾波器是統計意義下最優的。在最小均方誤差準則下,橫向濾波器的代價函式為:(2.118)橫向濾波器的代價函式是濾波器抽頭權值...

《隨機最優控制問題相關的Hamilton-Jacobi-Bellman方程及其弱解研究》是依託中國海洋大學,由魏立峰擔任項目負責人的青年科學基金項目。中文摘要 本項目研究代價函式由倒向隨機微分方程(BSDE)的解刻畫的隨機最優控制問題及其在實際中的套用。

Step2.根據已知的樣本圖像,對運動目標進行離線灰度分析和計算,給出圖像中運動目標提取灰度投影特徵閾值,灰度峰谷點投影特徵的閾值,代價函式的閾值以及運動目標的二維灰度投影模式向量的初始值。Step3.離線訓練,修正初始閾值。基於步驟2...

參與者的這兩種策略可以通過效用函式和代價函式來衡量。因此通過最大化效用函式和最小化代價函式,來追求利益的最大化。文獻[36]中提出一種基於博弈論的定價策略和網路選擇方案,該方案中服務提供商(Service Providers,SPs)為了提高自己...

哈密頓-雅可比-貝爾曼方程(Hamilton-Jacobi-Bellman equation,簡稱HJB方程)是一個偏微分方程,是最優控制的核心。HJB方程式的解是針對特定動態系統及相關代價函式下,有最小代價的實值函式。簡介 哈密頓-雅可比-貝爾曼方程(Hamilton-...

聚類質量用一個代價函式來表示。當一個中心點被某個非中心點替代時,除了未被替換的中心點外,其餘各點被重新分配。為了減輕k均值算法對孤立點的敏感性,k中心點算法不採用簇中對象的平均值作為簇中心,而選用簇中離平均值最近的對象...

在大多數我們已經學到的監督學習算法中類似於線性回歸邏輯回歸以及更多的算法,所有的這些算法都有一個最佳化目標函式或者某個代價函式需要通過算法進行最小化處理。事實上 K均值也有 一個最佳化目標函式或者需要最小化的代價函式。算法的第一...

其三,研究VSB系統在採用不同代價函式時的性能表現,包括誤差感測器的聲勢能密度和、聲動能密度和、聲能量密度和三種代價函式,研究表明考慮目標區域總降噪量和目標區域聲壓降低量均勻程度兩個方面,以聲能量密度和為代價函式是較好的選擇。...

被積函式中第一項 ,若x表示誤差矢量,那么 表示誤差的平方。由此可見,是用以衡量誤差x大小的代價函式,x越大,也就越大。Q(t)通常是對角線矩陣,對角線上的元素qii,分別表示相對應誤差分量xi的重視程度,越加被重視的誤差分量,...

研究成果簡介如下:(1)分步式無線感測器網路節點定位體系結構研究:該體系結構通過依次將未知節點作為偽錨節點對剩餘節點就行定位,突破現有的節點定位體系或者無法對代價函式加權,或者需要N維搜尋局限,為後續的節點定位算法的研究奠定基礎。

3.1.2 假設函式 51 3.1.3 決策邊界 52 3.2 邏輯回歸算法 53 3.2.1 代價函式 53 3.2.2 梯度下降算法 54 3.2.3 MATLAB最佳化函式 56 3.2.4 多項式邏輯回歸 58 3.3 多元分類 60 3.3.1 一對多 60 3.3.2 一對一...