基本介紹

- 中文名:激活函式

- 外文名:Activation Function

- 領域:神經網路

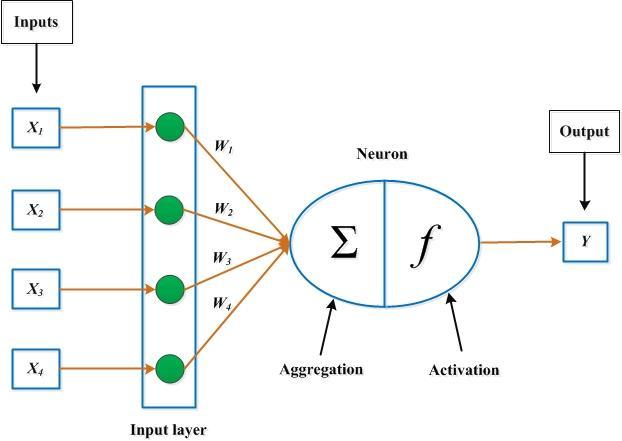

什麼是激活函式

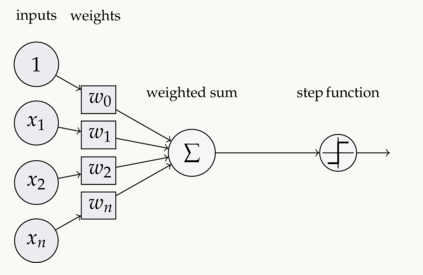

圖1

圖1為什麼要用激活函式

常用的激活函式

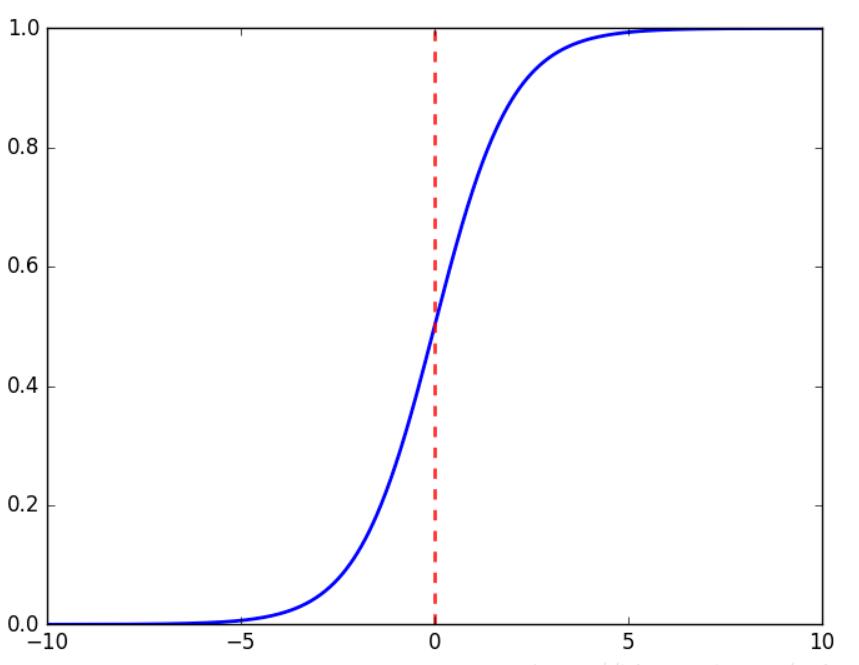

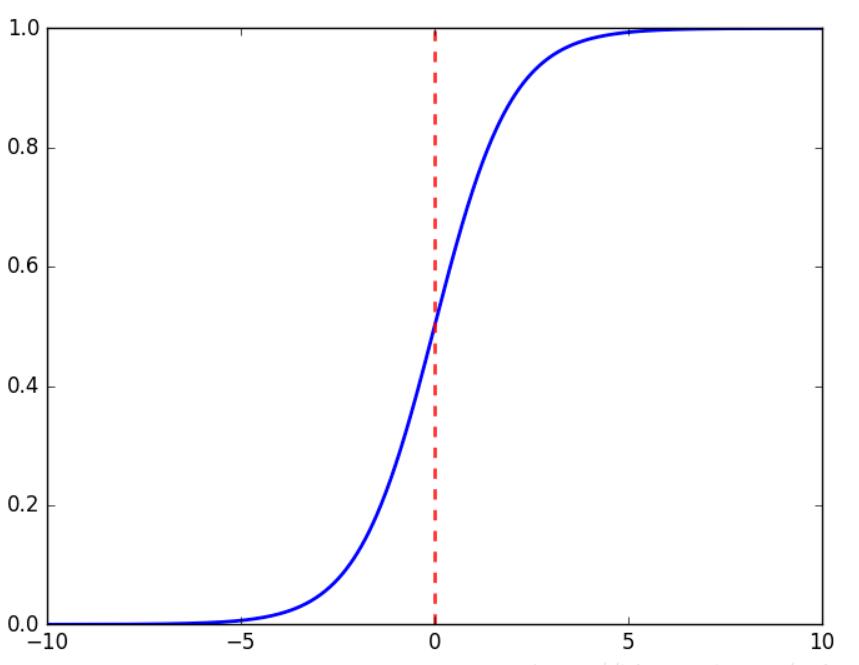

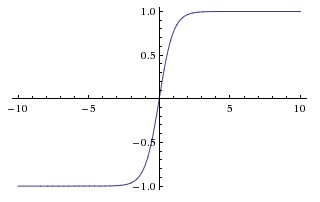

Sigmoid函式

Sigmoid 圖像

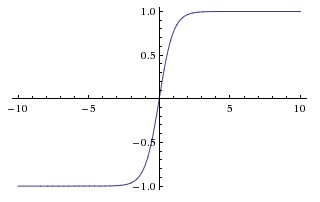

Sigmoid 圖像Tanh函式

Tanh函式圖像

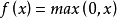

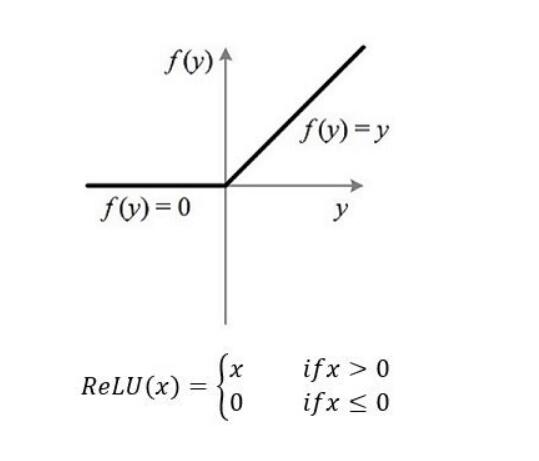

Tanh函式圖像ReLU函式

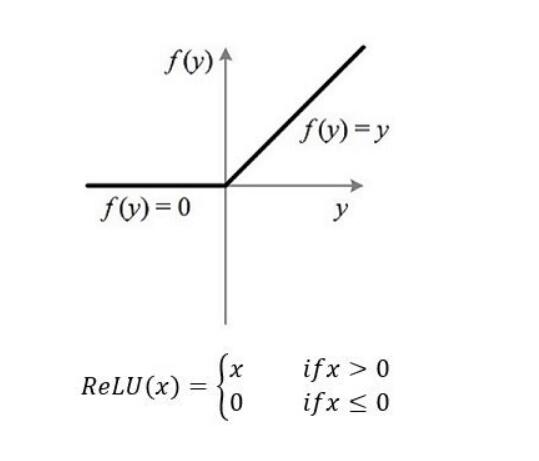

ReLU函式圖像

ReLU函式圖像

圖1

圖1

Sigmoid 圖像

Sigmoid 圖像

Tanh函式圖像

Tanh函式圖像

ReLU函式圖像

ReLU函式圖像所謂激活函式(Activation Function),就是在人工神經網路的神經元上運行的函式,負責將神經元的輸入映射到輸出端。...

激活函式的作用是給神經網路加入一些非線性因素,由於線性模型的表達能力不夠,故激活函式的加入可以使得神經網路更好地解決較為複雜的問題。...

Sigmoid函式是一個在生物學中常見的S型函式,也稱為S型生長曲線。在信息科學中,由於其單增以及反函式單增等性質,Sigmoid函式常被用作神經網路的激活函式,將變數...

線性整流函式(Rectified Linear Unit, ReLU),又稱修正線性單元,是一種人工神經網路中常用的激活函式(activation function),通常指代以斜坡函式及其變種為代表的非線性...

在數學建模領域,徑向基函式網路(Radial basis function network,縮寫:RBF network)是一種使用徑向基函式作為激活函式的人工神經網路。徑向基函式網路的輸出是輸入的...

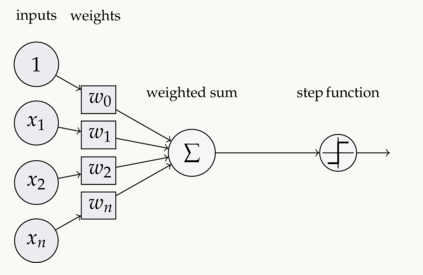

newp函式是創建一個感知器神經網路的函式。...... S表示神經元的個數;TF表示感知器的激活函式,預設值為硬限幅激活函式hardlim;LF表示網路的學習函式,預設值為learnp...

線性整流函式(Rectified Linear Unit, ReLU),又稱修正線性單元, 是一種人工神經網路中常用的激活函式(activation function),通常指代以斜坡函式及其變種為代表的非...

S型函式(Sigmoid function)是BP神經網路中常用的非線性作用函式,即sigmoid函式,公式是f(x)=1/(1+e^-x)(-x是冪數)。Sigmoid函式又分為Log-Sigmoid函式和Tan-...

使用ReLU 後,會發現激活函式之後的值沒有了tanh、sigmoid函式那樣有一個值域區間,所以一般在ReLU之後會做一個normalization,LRU就是穩重提出一種方法,在神經科學中有...

和激活函式 之後,就可以由前往後計算,依次算出所有的 值, 值,最終算出輸出層的 值。這就是前向傳播算法。正向傳播算法DNN前向傳播算法 編輯 有...

在數學建模領域,徑向基函式網路(Radial basis function network,縮寫 RBF network)是一種使用徑向基函式作為激活函式的人工神經網路。徑向基函式網路的輸出是輸入的...