遞歸網路是一種表示學習,它可以將詞、句、段、篇按照他們的語義映射到同一個向量空間中,也就是把可組合(樹/圖結構)的信息表示為一個個有意義的向量。

基本介紹

- 中文名:遞歸網路

- 套用領域:深度學習

遞歸網路是一種表示學習,它可以將詞、句、段、篇按照他們的語義映射到同一個向量空間中,也就是把可組合(樹/圖結構)的信息表示為一個個有意義的向量。

遞歸網路是一種表示學習,它可以將詞、句、段、篇按照他們的語義映射到同一個向量空間中,也就是把可組合(樹/圖結構)的信息表示為一個個有意義的向量。...

遞歸神經網路(recursive neural network)是具有樹狀階層結構且網路節點按其連線順序對輸入信息進行遞歸的人工神經網路(Artificial Neural Network, ANN),是深度學習(deep...

《立方形遞歸網路》是2002年大連海事學院出版社出版的圖書,作者是王德強。...... 《立方形遞歸網路》是2002年大連海事學院出版社出版的圖書,作者是王德強。...

2016年6月,在倫敦科幻電影節上,由紐約大學AI研究人員開發的遞歸神經網路“班傑明(Benjamin)”寫出了一部科幻電影,成為本屆電影節48小時電影製作挑戰賽的參賽作品之...

擴展轉移網路,在遞歸轉移網路上附加若干控制技術所形成的網路,而遞歸轉移網路又是擴展的有限狀態轉移圖,因此擴展轉移網路既可看成是語法的模型,又可看成是自動機的...

轉移網路語法也稱擴充轉移網路(Augmented Transition Network,簡稱ATN),就是用上下文無關文法的擴充來實現上下文相關文法,它是用一組暫存器存放語法分析信息。它每走一...

本書對遞歸人工神經網路進行了定性的分析。首先介紹了幾種神經網路模型,包括:模擬Hopfield神經網路;具有Sigmoid激活函式或飽和非線性激活函式的Hopfield同步離散神經網路;...

圖網路(Graph Network, GN)是在拓撲空間(topological space)內按圖(graph)結構組織以進行關係推理(relational reasoning)的函式集合。在深度學習理論中是圖神經網路(...

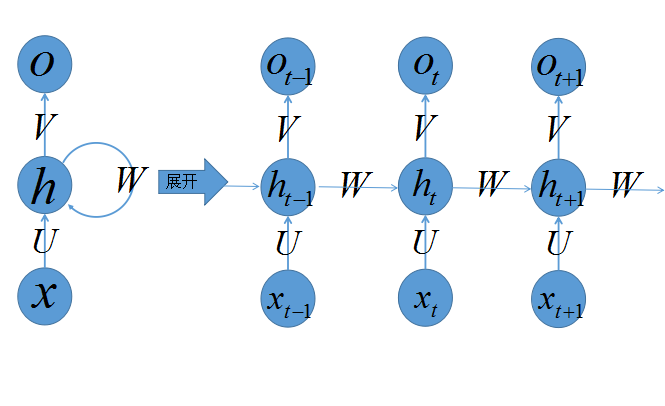

循環神經網路(Recurrent Neural Network, RNN)是一類以序列(sequence)數據為輸入,在序列的演進方向進行遞歸(recursion)且所有節點(循環單元)按鏈式連線的遞歸神經網路(...

本書包含四個組成部分:導論,監督學習,無監督學習,神經網路動力學模型。導論部 分介紹神經元模型、神經網路結構和機器學習的基本概念和理論。監督學習討論感知機學習 ...

ESN是Echo State Network 的縮寫,即回聲狀態網路,是一種新型的人工神經網路。...... 一種新型的人工神經網路 ESN是Jaeger於2001年提出一種新型遞歸神經網路,ESN一...

Hopfield神經網路是一種遞歸神經網路,由約翰·霍普菲爾德在1982年發明。...... Hopfield神經網路是一種遞歸神經網路,由約翰·霍普菲爾德在1982年發明。Hopfield網路是一種...

由開關元件按一定拓撲結構和控制方式構成的網路以實現計算機系統內部多個處理機或多個功能部件間的相互連線。在並行處理計算機系統、分布計算機系統和計算機網等由多個...

Batcher歸併網路是Batcher提出來的,由一系列Batcher比較器(Batcher's Comparator)組成的。Batcher比較器是指在兩個輸入端給定輸入x, y,再在兩個輸出端輸出最大值和...

本專著以神經動力系統的定性穩定性研究為核心,結合網路時代形成的複雜網路和多智慧型體系統的動態特性展開深入地擴展和延拓,形成複雜神經動力網路的穩定性研究脈絡。《...

廣義的無阻塞網路指一個給定的網路存在著固有的阻塞可能,但又可能存在著一種精巧的選路方法,使得所有的阻塞均可避免,而不必重新安排網路中已建立起來的連線.嚴格...

國際網際網路就是指網際網路。網際網路(Internetwork)是一組全球信息資源的總匯。有一種粗略的說法,認為INTERNET是由於許多小的網路(子網)互聯而成的一個邏輯網,每個子...

網路爬蟲(又被稱為網頁蜘蛛,網路機器人,在FOAF社區中間,更經常的稱為網頁追逐者),是一種按照一定的規則,自動地抓取全球資訊網信息的程式或者腳本。另外一些不常使用的...

網路晶片(networking processor)是一個提供在通信網路中傳送和接收數據邏輯(包括聲音和視頻)的微處理器,有了它之後其他的附加設備就不需要這些功能了。...