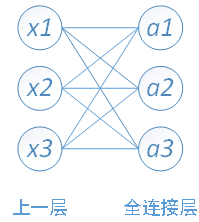

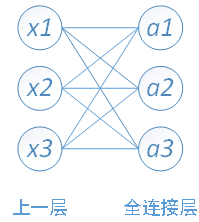

全連線層的每一個結點都與上一層的所有結點相連,用來把前邊提取到的特徵綜合起來。由於其全相連的特性,一般全連線層的參數也是最多的。例如在VGG16中,第一個全連線層FC1有4096個節點,上一層POOL2是7*7*512 = 25088個節點,則該傳輸需要4096*25088個權值,需要耗很大的記憶體。

基本介紹

- 中文名:全連線層

- 外文名:Fully connected layer

全連線層的前向傳播

圖1

圖1

全連線層的每一個結點都與上一層的所有結點相連,用來把前邊提取到的特徵綜合起來。由於其全相連的特性,一般全連線層的參數也是最多的。例如在VGG16中,第一個全連線層FC1有4096個節點,上一層POOL2是7*7*512 = 25088個節點,則該傳輸需要4096*25088個權值,需要耗很大的記憶體。

圖1

圖1

全連線層的每一個結點都與上一層的所有結點相連,用來把前邊提取到的特徵綜合起來。由於其全相連的特性,一般全連線層的參數也是最多的。例如在VGG16中,第一個全...

(1*1+2*2+3*3)*256=14*256=3584個神經元,即無論前面的feature map是多大的,經過spp layer處理之後得到固定大小的神經元,然後就可以和全連線層進行矩陣運算...

卷積神經網路的隱含層包含卷積層、池化層和全連線層3類常見構築,在一些更為現代的算法中可能有Inception模組、殘差塊(residual block)等複雜構築。在常見構築中,...

圖四是VGG網路最後三層的替換過程,上半部分是訓練階段,此時最後三層都是全連線層(輸出分別是4096、4096、1000),下半部分是測試階段(輸出分別是1x1x4096、1x1x...

圖一 圖一示意了局部連線,每一個W只與輸入的一部分連線,如果W1和W2是相同的,那么就是卷積層,這時參數W(1)和W(2)相同,因此說共享。...

activation表示該全連線層使用的激活函式,接收一個激活函式對象,例如keras.activations.sigmoid,也可接收關鍵字,例如'sigmoid',使用關鍵字時該激活函式類的參量取默認...

在社會學領域,一般通過給定網路的拓撲結構定義網路節點間的相似性或距離,然後採用單連線層次聚類或全連線層次聚類將網路節點組成一個樹狀圖層次結構。其中,樹的葉節點...

卷積神經網路所取得的各種優異表現直接推動了卷積自編碼器的產生。嚴格上來說,卷積自編碼器屬於傳統自編碼器的一個特例,它使用卷積層和池化層替代了原來的全連線層...

(X) # 跳躍連線 X = keras.layers.Add()([X, X_shortcut]) X = keras.layers.Activation('relu')(X) return X def convolutional_block(X, f, ...

網路裁剪可以按粒度分為層級裁剪,神經元級裁剪和神經連線級裁剪。層級裁剪的裁減對象是網路層,裁剪的結果是獲得更淺的網路。神經網路壓縮需求 編輯 ...

首先介紹CNN的歷史演變過程,並對其5個層級結構(輸入層、卷積運算層、激勵層、池化層、全連線層)和4個基本運算單元(卷積運算、池化運算、全連線運算和識別運算)...

通過閱讀《深度學習入門之PyTorch》,你將學到機器學習中的線性回歸和 Logistic 回歸、深度學習的最佳化方法、多層全連線神經網路、卷積神經網路、循環神經網路,以及生成...