全連線層的每一個結點都與上一層的所有結點相連,用來把前邊提取到的特徵綜合起來。由於其全相連的特性,一般全連線層的參數也是最多的。例如在VGG16中,第一個全連線層FC1有4096個節點,上一層POOL2是7*7*512 = 25088個節點,則該傳輸需要4096*25088個權值,需要耗很大的記憶體。

基本介紹

- 中文名:全連線層

- 外文名:Fully connected layer

全連線層的前向傳播,卷積神經網路的全連線層,

全連線層的前向傳播

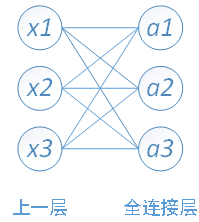

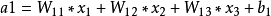

下面圖1用一個簡單的網路具體介紹一下推導過程:

圖1

圖1其中,x1、x2、x3為全連線層的輸入,a1、a2、a3為輸出,

卷積神經網路的全連線層

在 CNN 結構中,經多個卷積層和池化層後,連線著1個或1個以上的全連線層.與 MLP 類似,全連線層中的每個神經元與其前一層的所有神經元進行全連線.全連線層可以整合卷積層或者池化層中具有類別區分性的局部信息.為了提升 CNN 網路性能,全連線層每個神經元的激勵函式一般採用 ReLU 函式。最後一層全連線層的輸出值被傳遞給一個輸出,可以採用 softmax 邏輯回歸(softmax regression)進行 分 類,該層也可 稱為 softmax 層(softmax layer).對於一個具體的分類任務,選擇一個合適的損失函式是十分重要的,CNN 有幾種常用的損失函式,各自都有不同的特點.通常,CNN 的全連線層與 MLP 結構一樣,CNN 的訓練算法也多採用BP算法.