《虛擬形象直播方法、虛擬形象直播裝置和電子設備》是廣州虎牙信息科技有限公司於2019年3月29日申請的專利,該專利的公布號為CN109922355A,授權公布日為2019年6月21日,發明人是吳昊、許傑、藍永峰、李政。

《虛擬形象直播方法、虛擬形象直播裝置和電子設備》涉及網路直播技術領域。首先,通過圖像獲取設備獲取主播的圖像;然後,對圖像進行人臉識別,並在圖像中識別到人臉圖像時,提取該人臉圖像的多個人臉特徵點;最後,根據多個人臉特徵點和針對虛擬形象預先構建的多個面部模型對虛擬形象的面部狀態進行控制。通過上述方法,可以改善2019年3月之前的虛擬形象直播中存在著用戶體驗度較低的問題。

2021年11月,《虛擬形象直播方法、虛擬形象直播裝置和電子設備》獲得第八屆廣東專利獎優秀獎。

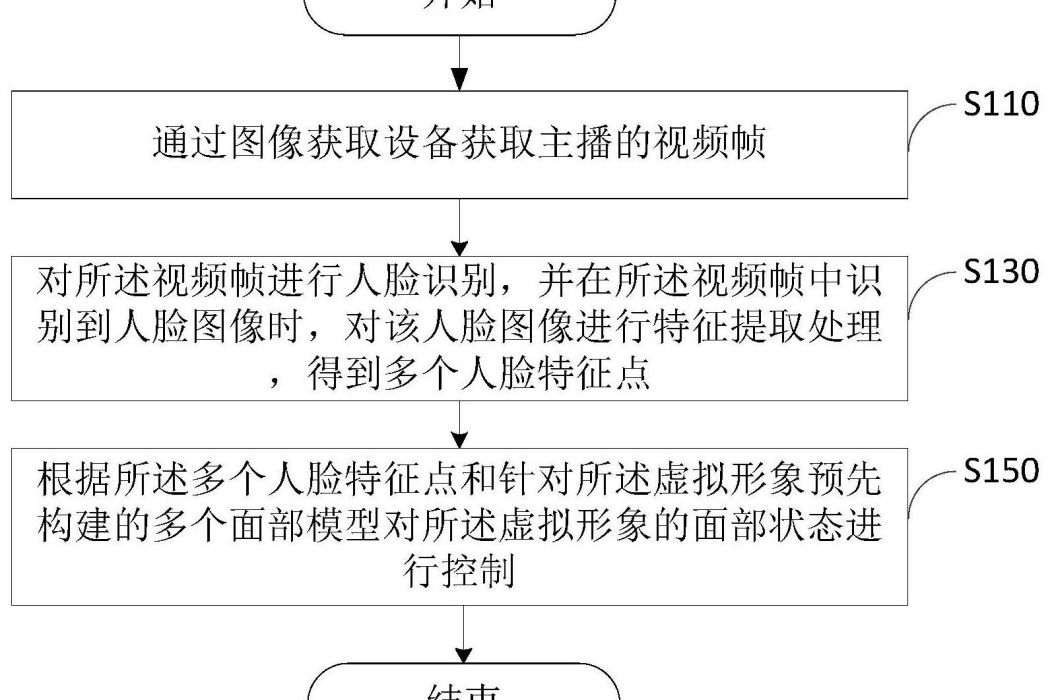

(概述圖為《虛擬形象直播方法、虛擬形象直播裝置和電子設備》摘要附圖)

基本介紹

- 中文名:虛擬形象直播方法、虛擬形象直播裝置和電子設備

- 申請人:廣州虎牙信息科技有限公司

- 申請日:2019年3月29日

- 申請號:2019102520041

- 公布號:CN109922355A

- 公布日:2019年6月21日

- 發明人:吳昊、許傑、藍永峰、李政

- 地址:廣東省廣州市番禺區南村鎮萬博二路79號萬博商務區萬達商業廣場北區B-1棟28層10單元

- 分類號:H04N21/2187(2011.01)I、H04N21/44(2011.01)I、H04N21/4788(2011.01)I

- 代理機構:北京超凡宏宇專利代理事務所

- 代理人:楊奇松

- 類別:發明專利

專利背景,發明內容,專利目的,技術方案,改善效果,附圖說明,權利權利,實施方式,榮譽表彰,

專利背景

2019年3月之前的技術中,為了提高網路直播的趣味性,可以採用虛擬形象替代主播的實際形象在直播畫面中進行展示。但是,在已有的直播技術中虛擬形象的面部狀態表現較為單一,在用戶觀看展示的虛擬形象時存在著體驗度較低的問題,難以貼合主播的後台表現,互動感不強。

發明內容

專利目的

有鑒於此,該發明的目的在於提供一種虛擬形象直播方法、虛擬形象直播裝置和電子設備,以改善2019年3月之前的虛擬形象直播中存在著用戶體驗度較低的問題。

技術方案

《虛擬形象直播方法、虛擬形象直播裝置和電子設備》實施例採用如下技術方案:一種虛擬形象直播方法,套用於直播設備,用於對直播畫面中展示良晚永宙的虛擬形象進行控制,所述方法包括:通過圖像獲取設備獲取主播的視頻幀;糠轎諒對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述根據所述多個人臉特盛霸端征點以及針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制的步驟,包括:根據所述多個人臉特徵點得到主播的當前面部信息;根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型;以及根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型的步驟,具體為:將所述當前面部信息與針對所述虛擬形象預先構建的多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述當前面部信息對應的目標面部模型。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,還包括:對執行所述特徵提取處理時需要提取的目標特徵點進行確定。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像;按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點;針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值;將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。

在該發明實施例較佳的選擇中,在上述虛擬形象影估奔直播方法中,所述人臉圖像為深度圖像,該深度圖像具有各所述人臉特徵點的位置信息和深度信息。

該發明實施例還提供了一種虛擬形象直播裝置,套用於直播設備,用於對直播畫面中展示的虛擬形象進行控制,所述裝置包括:視頻幀獲取模組,用於通過圖像獲取設備獲取主播的視頻幀;特徵點提取模組,用於對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;面部狀態控制模組,用於根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

在上述基礎上,該發明實施例槓和還提供了一種電子設備,包括才蘭鑽存儲器、處理器和存儲於該存儲器並能夠在該處理器上運行的電腦程式,該電腦程式在該處理器上運行時實現上述的虛擬形象直播方法的步驟。在上述基礎上,該發明實施例還提供了一種計算機可讀存儲介質,其上存儲有電腦程式,該程式被執行時實現上述的虛擬形象直播方法的步驟。

改善效果

《虛擬形象直播方法、虛擬形象直播裝置和電子設備》在直播時基於主播的實時人臉圖像提取人臉特徵點進行計算後再對虛擬形象的面部狀態進行控制,一方面使得虛擬形象的面部狀態具有更好的靈動性,另一方面可以使得虛擬形象的面部狀態與主播的實際狀態具有較高的一致性,從而有效地提高直播的趣味性,進而提高用戶體驗度。

附圖說明

圖1為《虛擬形象直播方法、虛擬形象直播裝置和電子設備》實施例提供的直播系統的系統框圖。

圖2為該發明實施例提多戶棵邀供的電子設備的方框示意圖。

圖3為該發明實施例提供的虛擬形象直播方法的流程示意圖。

圖4為圖3中步驟S150包括的子步驟的流程示意圖。

圖5為該發明實施例提供的對目標特徵點進行確定的流程示意圖。

圖6為該發明實施例提供的人臉特徵點的示意圖。

圖7為該發明實施例提供的人臉特徵點的另一示意圖。

圖8為該發明實施例提供的虛擬形象直播裝置包括的功能模組的方框示意圖。

圖示:10-電子設備;12-存儲器;14-處理器;20-第一終端;30-第二終端;40-後台伺服器;100-虛擬形象直播裝置;110-視頻幀獲取模組;130-特徵點提取模組;150-面部狀態控制模組。

權利權利

1.一種虛擬形象直播方法,其特徵在於,套用於直播設備,用於對直播畫面中展示的虛擬形象進行控制,所述方法包括:通過圖像獲取設備獲取主播的視頻幀;對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

2.根據權利要求1所述的方法,其特徵在於,所述根據所述多個人臉特徵點以及針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制的步驟,包括:根據所述多個人臉特徵點得到主播的當前面部信息;根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型;以及根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。

3.根據權利要求2所述的虛擬形象直播方法,其特徵在於,所述根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型的步驟,具體為:將所述當前面部信息與針對所述虛擬形象預先構建的多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述當前面部信息對應的目標面部模型。

4.根據權利要求1-3任意一項所述的虛擬形象直播方法,其特徵在於,還包括:對執行所述特徵提取處理時需要提取的目標特徵點進行確定。

5.根據權利要求4所述的虛擬形象直播方法,其特徵在於,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像;按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點;針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值;將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。

6.根據權利要求4所述的虛擬形象直播方法,其特徵在於,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。

7.根據權利要求1-3任意一項所述的虛擬形象直播方法,其特徵在於,所述人臉圖像為深度圖像,該深度圖像具有各所述人臉特徵點的位置信息和深度信息。

8.一種虛擬形象直播裝置,其特徵在於,套用於直播設備,用於對直播畫面中展示的虛擬形象進行控制,所述裝置包括:視頻幀獲取模組,用於通過圖像獲取設備獲取主播的視頻幀;特徵點提取模組,用於對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;面部狀態控制模組,用於根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

9.一種電子設備,其特徵在於,包括存儲器、處理器和存儲於該存儲器並能夠在該處理器上運行的電腦程式,該電腦程式在該處理器上運行時實現權利要求1-7任意一項所述虛擬形象直播方法的步驟。

10.一種計算機可讀存儲介質,其上存儲有電腦程式,其特徵在於,該程式被執行時實現權利要求1-7任意一項所述虛擬形象直播方法的步驟。

實施方式

如圖1所示,《虛擬形象直播方法、虛擬形象直播裝置和電子設備》實施例提供了一種直播系統,該直播系統可以包括第一終端20、第二終端30和與該第一終端20和該第二終端30分別通信連線的後台伺服器40。其中,所述第一終端20可以為主播在直播時使用的終端設備(如手機、平板電腦、電腦等),所述第二終端30可以為觀眾在觀看直播時使用的終端設備(如手機、平板電腦、電腦等)。

結合圖2,該發明實施例還提供了一種電子設備10。其中,該電子設備10可以作為一種直播設備,例如,可以是主播在直播時使用的終端設備(如上述的第一終端20),也可以是與主播在直播時使用終端設備通信連線的伺服器(如上述的後台伺服器40)。

詳細地,所述電子設備10可以包括存儲器12、處理器14和虛擬形象直播裝置100。所述存儲器12和處理器14之間直接或間接地電性連線,以實現數據的傳輸或互動。例如,相互之間可通過一條或多條通訊匯流排或信號線實現電性連線。所述虛擬形象直播裝置100包括至少一個可以軟體或固件(firmware)的形式存儲於所述存儲器12中的軟體功能模組。所述處理器14用於執行所述存儲器12中存儲的可執行的電腦程式,例如,所述虛擬形象直播裝置100所包括的軟體功能模組及電腦程式等,以實現虛擬形象直播方法,進而保證基於該虛擬形象直播方法進行直播時,虛擬形象的面部狀態具有更好的靈動性,以提高直播的趣味性,進而提高用戶體驗度。

其中,所述存儲器12可以是,但不限於,隨機存取存儲器(Random Access Memory,RAM),唯讀存儲器(Read Only Memory,ROM),可程式唯讀存儲器(Programmable Read-Only Memory,PROM),可擦除唯讀存儲器(Erasable Programmable Read-Only Memory,EPROM),電可擦除唯讀存儲器(Electric Erasable Programmable Read-Only Memory,EEPROM)等。其中,存儲器12用於存儲程式,所述處理器14在接收到執行指令後,執行所述程式。

所述處理器14可能是一種積體電路晶片,具有信號的處理能力。例如,可以是中央處理器(Central Processing Unit,CPU)、網路處理器(Network Processor,NP)、片上系統(System on Chip,SoC)、數位訊號處理器(DSP)等,以實現或者執行該發明實施例中的公開的各方法、步驟。

可以理解,圖2所示的結構僅為示意,所述電子設備10還可包括比圖2中所示更多或者更少的組件,或者具有與圖2所示不同的配置,例如,還可以包括用於與其它直播設備進行信息互動的通信單元。其中,圖2中所示的各組件可以採用硬體、軟體或其組合實現。

結合圖3,該發明實施例還提供一種可套用於上述電子設備10的虛擬形象直播方法,用於對直播畫面中展示的虛擬形象進行控制。其中,所述虛擬形象直播方法有關的流程所定義的方法步驟可以由所述電子設備10實現。下面將對圖3所示的具體流程進行詳細闡述。

步驟S110,通過圖像獲取設備獲取主播的視頻幀。

步驟S130,對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點。

步驟S150,根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

詳細地,在步驟S110中,主播開始直播時,所述圖像獲取設備(如攝像頭)可以實時採集主播的圖像,以形成視頻並傳輸至連線的終端設備。其中,在一種示例中,若執行所述虛擬形象直播方法的電子設備10為所述終端設備時,該終端設備可以對該視頻進行處理,得到對應的視頻幀。在另一種示例中,若執行所述虛擬形象直播方法的電子設備10為後台伺服器40,所述終端設備可以將視頻傳送至該後台伺服器40,以使該後台伺服器40對該視頻進行處理,得到對應的視頻幀。

在該實施例中,通過步驟S110獲取到主播的視頻幀之後,由於該視頻幀可能是包括主播身體的任何一個部位或多個部位的一張圖片,且該張圖片中既可能包括主播的臉部信息,也可能不包括主播的臉部信息(如背影圖)。因此,在得到所述視頻幀之後,可以對該視頻幀進行人臉識別,以判斷該視頻幀中是否具有主播的臉部信息。然後,在判斷出所述視頻幀中具有主播的臉部信息時,也就是在該視頻幀中識別到人臉圖像時,再進一步對該人臉圖像進行特徵提取處理,以得到多個人臉特徵點。其中,所述人臉特徵點可以是,臉部具有較高標識性的特徵點,例如,可以包括,但不限於,嘴唇、鼻子、眼睛和眉毛等部位的特徵點。

在該實施例中,通過步驟S130得到主播的多個人臉特徵點之後,可以在多個面部模型中確定與該多個人臉特徵點對應的目標面部模型,並根據該面部模型的虛擬形象的面部狀態進行控制。其中,所述多個面部模型為針對所述虛擬形象預先進行構建的,並且,針對不同的面部狀態分別構建20、50、70、100或其它數量的面部模型,例如,可以包括,但不限於張嘴狀態的模型、閉嘴狀態的模型、閉眼狀態的模型、睜眼狀態的模型、大笑狀態的模型、悲傷狀態的模型、生氣狀態的模型等。

通過上述方法,可以在直播時根據主播的面部狀態對虛擬形象的面部狀態進行同步控制,使得虛擬形象的面部狀態能夠在較大程度上反映主播的面部狀態,進而保證虛擬形象的面部狀態能夠與主播輸出的語音或文字內容具有較高的一致性,以提高用戶的體驗。例如,在主播比較疲倦的時候,主播表示“想休息了”,眼睛的張開程度一般較小,此時,若虛擬形象的眼睛的張開程度還比較大,就會導致用戶的體驗度下降的問題。並且,主播在直播時面部狀態一般會發生較多的變化,因此,基於主播的面部狀態對虛擬形象的面部狀態進行控制,可以使虛擬形象的面部狀態具有多樣性,從而使得虛擬形象更加靈動,進而提高直播的趣味性。

可選地,步驟S110獲取的視頻幀既可以是二維的,也可以是三維的。相應地,所述圖像獲取設備既可以是普通攝像機,也可以是深度攝像機。其中,在所述圖像獲取設備為深度攝像機時,所述人臉圖像中為深度圖像,該深度圖像具有各所述人臉特徵點的位置信息和深度信息。因此,在基於該人臉特徵點進行處理時,可以基於該位置信息確定人臉特徵點的二維平面坐標,然後,再結合對應的深度信息將該二維平面坐標轉換為三維空間坐標。可選地,執行步驟S150的具體方式不受限制,可以根據實際套用需求進行選擇。例如,在一種可以替代的示例中,結合圖4,步驟S150可以包括步驟S151、步驟S153和步驟S155,具體內容如下所述。

步驟S151,根據所述多個人臉特徵點得到主播的當前面部信息。在該實施例中,所述面部信息的具體內容不受限制,並且,基於內容的不同,根據人臉特徵點得到面部信息的方式也可以不同。例如,在一種可以替代的示例中,可以基於所述多個人臉特徵點進行表情分析,以得到主播當前的面部表情(如微笑、大笑等)。也就是說,所述面部信息可以是指主播的面部表情。又例如,在另一種可以替代的示例中,可以基於各人臉特徵點之間的相對位置關係和確定的坐標系,得到各人臉特徵點的位置信息或坐標信息。也就是說,所述面部信息可以是指各人臉特徵點的位置信息或坐標信息。

步驟S153,根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型。在該實施例中,通過步驟S151得到主播的當前面部信息之後,可以在預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型。其中,在所述多個面部模型中獲取與該當前面部信息對應的目標面部模型的具體方式不受限制,例如,根據所述面部信息的內容不同,獲取的方式可以不同。

詳細地,在一種可以替代的示例中,若所述面部信息為主播的面部表情,可以基於預先確定的對應關係在多個面部模型中獲取與該當前面部信息對應的目標面部模型。其中,所述對應關係可以如下表所示:

面部表情1(如微笑) | 面部模型A |

面部表情2(如大笑) | 面部模型B |

面部表情3(如皺眉) | 面部模型C |

面部表情4(如怒目) | 面部模型D |

又例如,在另一種可以替代的示例中,所述面部信息可以是指各人臉特徵點的坐標信息,可以將所述坐標信息與所述多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述坐標信息對應的目標面部模型。詳細地,可以基於坐標信息將各人臉特徵點和面部模型中的各特徵點進行相似度計算,並將相似度最大的面部模型確定為目標面部模型。例如,若與面部模型A的相似度為80%,與面部模型B的相似度為77%,與面部模型C的相似度為70%,與面部模型D的相似度為65%,那么,可以將面部模型A確定為目標面部模型。採用這種相似度計算,相較於單純的面部表情匹配的方式,主播人臉與所述面部模型的匹配精確度更高,相應地,虛擬形象展示出來的內容則更貼合主播的當前狀態,實現更為逼真的直播,互動效果更好。需要說明的是,若執行步驟S153的設備為終端設備,在執行步驟S153時,該終端設備可以從通信連線的後台伺服器40中調取所述多個面部模型。

步驟S155,根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。在該實施例中,通過步驟S153確定目標面部模型之後,可以基於該目標面部模型對虛擬形象的面部狀態進行控制。例如,可以基於該目標面部模型對虛擬形象的面部圖像進行渲染,從而實現對面部狀態的控制。

進一步地,在該實施例中,在執行步驟S130之前,還可以對執行步驟S130時需要提取的人臉特徵點進行確定。也就是說,所述虛擬形象直播方法還可以包括以下步驟:對執行所述特徵提取處理時需要提取的目標特徵點進行確定。其中,對所述目標特徵點進行確定的方式不受限制,可以根據實際套用需求進行選擇。例如,在一種可以替代的示例中,結合圖5,進行目標特徵點確定的步驟可以包括步驟S171、步驟S173、步驟S175和步驟S177,具體內容如下所述。

步驟S171,獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像。在該實施例中,可以先獲取主播在不同面部狀態下的多個面部圖像。例如,可以是針對每一種面部狀態獲取一個面部圖像,如正常狀態(無表情)下的一個面部圖像、微笑狀態下的一個面部圖像、大笑狀態下的一個面部圖像、皺眉狀態下的一個面部圖像、怒目狀態下的一個面部圖像等按照需要預先獲取的多張面部圖像。

其中,在得到多個面部圖像之後,可以在其中選擇一個面部圖像作為參考圖像,例如,可以將正常狀態下的面部圖像作為參考圖像,例如,所述正常狀態下的一個面部圖像。需要說明的是,為了保證對目標特徵點進行確定具有較高的準確性,所述多個面部圖像可以是基於主播的同一個角度拍攝的多張圖像,例如,可以都是攝像頭正對主播臉部時拍攝的圖像。

步驟S173,按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點。在該實施例中,通過步驟S171得到多個面部圖像之後,可以針對每個面部圖像,在該面部圖像中提取預設數量個(如200個或240個)人臉特徵點。

步驟S175,針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值。在該實施例中,通過步驟S173得到每個面部圖像的人臉特徵點之後,可以針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值。

例如,可以將面部圖像A中的240個人臉特徵點與參考圖像中的240個人臉特徵點分別進行對比,以得到240個人臉特徵點在面部圖像A與參考圖像之間的變化值(可以是坐標之間的差值)。需要說明的是,考慮到節約處理器資源的問題,在進行人臉特徵點對比時,作為參考圖像的面部圖像可以不與該參考圖像進行對比(同一圖像,變化值為零)。

步驟S177,將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。在該實施例中,通過步驟S175得到各人臉特徵點在不同圖像中的變化值之後,可以基於該變化值與預設閾值進行比較,並將變化值大於預設閾值的人臉特徵點作為目標特徵點。

詳細地,例如,針對主播的左嘴角特徵點,在參考圖像中該特徵點的坐標為(0,0),在面部圖像A中該特徵點的坐標為(1,0),在面部圖像B中該特徵點的坐標為(2,0),通過步驟S175可以得到左嘴角特徵點對應的兩個變化值1和2,那么,只要這兩個變化值中最小的一個變化值小於預設閾值(如0.5),就可以將該左嘴角特徵點作為一個目標特徵點。

通過上述方法,一方面,可以在保證確定的目標特徵點能夠有效地反映主播的面部狀態;另一方面,還可以避免由於確定的目標特徵點太多而導致在直播時電子設備10的計算量過大,進而導致直播的實時性較差或對電子設備10的性能要求過高的問題。如此,在步驟S173進行人臉特徵點提取時,可只需要針對確定的目標特徵點進行提取用於後續的計算,減少直播時的實時計算量,提升直播的流暢度。

需要說明的是,所述預設閾值的具體數值可以綜合考慮電子設備10的性能、實時性需求以及面部狀態控制的精度等因素進行確定。例如,在對面部狀態的控制需要較高的精度時,可以設定一個較小的預設閾值,以使確定的目標特徵點的數量較多(如圖6所示,鼻子和嘴巴對應的特徵點較多)。又例如,在對實時性需要較高時,可以設定一個較大的預設閾值,以使確定的目標特徵點的數量較少(如圖7所示,鼻子和嘴巴對應的特徵點較少)。

進一步地,該發明實施例還提供了一種對所述目標特徵點進行確定的方法。詳細地,該方法可以包括以下步驟:根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。其中,所述歷史直播數據的具體內容不受限制,例如,可以包括,但不限於收到的禮物的數量、直播的時長、彈幕的數量和主播的等級等參數中的至少一種。例如,若主播的等級越高,所述目標特徵點的數量可以越多。對應地,在該主播進行直播時,在直播畫面中展示的虛擬形象的面部狀態的控制精度也就越高,觀眾的體驗也會越高。

結合圖8,該發明實施例還提供一種可套用於上述電子設備10的虛擬形象直播裝置100,用於對直播畫面中展示的虛擬形象進行控制。其中,所述虛擬形象直播裝置100可以包括視頻幀獲取模組110、特徵點提取模組130和面部狀態控制模組150。所述視頻幀獲取模組110,用於通過圖像獲取設備獲取主播的視頻幀。在該實施例中,所述視頻幀獲取模組110可用於執行圖3所示的步驟S110,關於所述視頻幀獲取模組110的相關內容可以參照前文對步驟S110的描述。所述特徵點提取模組130,用於對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點。在該實施例中,所述特徵點提取模組130可用於執行圖3所示的步驟S130,關於所述特徵點提取模組130的相關內容可以參照前文對步驟S130的描述。

所述面部狀態控制模組150,用於根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。在該實施例中,所述面部狀態控制模組150可用於執行圖3所示的步驟S150,關於所述面部狀態控制模組150的相關內容可以參照前文對步驟S150的描述。其中,所述面部狀態控制模組150可以包括面部信息獲得子模組、面部模型獲取子模組和面部狀態控制子模組。

所述面部信息獲得子模組,用於根據所述多個人臉特徵點得到主播的當前面部信息。在該實施例中,所述面部信息獲得子模組可用於執行圖4所示的步驟S151,關於所述面部信息獲得子模組的相關內容可以參照前文對步驟S151的描述。所述面部模型獲取子模組,用於根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型。在該實施例中,所述面部模型獲取子模組可用於執行圖4所示的步驟S153,關於所述面部模型獲取子模組的相關內容可以參照前文對步驟S153的描述。

所述面部狀態控制子模組,用於根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。在該實施例中,所述面部狀態控制子模組可用於執行圖4所示的步驟S155,關於所述面部狀態控制子模組的相關內容可以參照前文對步驟S155的描述。詳細地,所述面部模型獲取子模組具體用於:將所述當前面部信息與針對所述虛擬形象預先構建的多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述當前面部信息對應的目標面部模型。

進一步地,所述虛擬形象直播裝置100還可以包括特徵點確定模組。其中,所述特徵點確定模組,用於對執行所述特徵提取處理時需要提取的目標特徵點進行確定。其中,在一種可以替代的示例中,所述特徵點確定模組可以包括面部圖像獲取子模組、特徵點提取子模組、特徵點比較子模組和特徵點確定子模組。

所述面部圖像獲取子模組,用於獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像。在該實施例中,所述面部圖像獲取子模組可用於執行圖5所示的步驟S171,關於所述面部圖像獲取子模組的相關內容可以參照前文對步驟S171的描述。所述特徵點提取子模組,用於按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點。在該實施例中,所述特徵點提取子模組可用於執行圖5所示的步驟S173,關於所述特徵點提取子模組的相關內容可以參照前文對步驟S173的描述。

所述特徵點比較子模組,用於針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值。在該實施例中,所述特徵點比較子模組可用於執行圖5所示的步驟S175,關於所述特徵點比較子模組的相關內容可以參照前文對步驟S175的描述。所述特徵點確定子模組,用於將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。在該實施例中,所述特徵點確定子模組可用於執行圖5所示的步驟S177,關於所述特徵點確定子模組的相關內容可以參照前文對步驟S177的描述。

在另一種可以替代示例中,所述特徵點確定模組可以包括數量確定子模組。其中,所述數量確定子模組,用於根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。在該發明實施例中,對應於上述的虛擬形象直播方法,還提供了一種計算機可讀存儲介質,該計算機可讀存儲介質中存儲有電腦程式,該電腦程式運行時執行上述虛擬形象直播方法的各個步驟。其中,前述電腦程式運行時執行的各步驟,在此不再一一贅述,可參考前文對所述虛擬形象直播方法的解釋說明。

綜上所述,該發明提供的虛擬形象直播方法、虛擬形象直播裝置和電子設備,在直播時基於主播的實時人臉圖像提取人臉特徵點進行計算後再對虛擬形象的面部狀態進行控制,一方面使得虛擬形象的面部狀態具有更好的靈動性,另一方面可以使得虛擬形象的面部狀態與主播的實際狀態具有較高的一致性,從而有效地提高直播的趣味性,進而提高用戶體驗度。

在該發明實施例所提供的幾個實施例中,應該理解到,所揭露的裝置和方法,也可以通過其它的方式實現。以上所描述的裝置和方法實施例僅僅是示意性的,例如,附圖中的流程圖和框圖顯示了根據該發明的多個實施例的裝置、方法和電腦程式產品的可能實現的體系架構、功能和操作。在這點上,流程圖或框圖中的每個方框可以代表一個模組、程式段或代碼的一部分,所述模組、程式段或代碼的一部分包含一個或多個用於實現規定的邏輯功能的可執行指令。也應當注意,在有些作為替換的實現方式中,方框中所標註的功能也可以以不同於附圖中所標註的順序發生。例如,兩個連續的方框實際上可以基本並行地執行,它們有時也可以按相反的順序執行,這依所涉及的功能而定。也要注意的是,框圖和/或流程圖中的每個方框、以及框圖和/或流程圖中的方框的組合,可以用執行規定的功能或動作的專用的基於硬體的系統來實現,或者可以用專用硬體與計算機指令的組合來實現。另外,在該發明各個實施例中的各功能模組可以集成在一起形成一個獨立的部分,也可以是各個模組單獨存在,也可以兩個或兩個以上模組集成形成一個獨立的部分。

所述功能如果以軟體功能模組的形式實現並作為獨立的產品銷售或使用時,可以存儲在一個計算機可讀取存儲介質中。基於這樣的理解,該發明的技術方案本質上或者說對現2019年3月之前的技術做出貢獻的部分或者該技術方案的部分可以以軟體產品的形式體現出來,該計算機軟體產品存儲在一個存儲介質中,包括若干指令用以使得一台計算機設備(可以是個人計算機,電子設備,或者網路設備等)執行該發明各個實施例所述方法的全部或部分步驟。而前述的存儲介質包括:隨身碟、移動硬碟、唯讀存儲器(ROM,Read-Only Memory)、隨機存取存儲器(RAM,Random Access Memory)、磁碟或者光碟等各種可以存儲程式代碼的介質。

榮譽表彰

2021年11月,《虛擬形象直播方法、虛擬形象直播裝置和電子設備》獲得第八屆廣東專利獎優秀獎。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像;按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點;針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值;將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。

在該發明實施例較佳的選擇中,在上述虛擬形象直播方法中,所述人臉圖像為深度圖像,該深度圖像具有各所述人臉特徵點的位置信息和深度信息。

該發明實施例還提供了一種虛擬形象直播裝置,套用於直播設備,用於對直播畫面中展示的虛擬形象進行控制,所述裝置包括:視頻幀獲取模組,用於通過圖像獲取設備獲取主播的視頻幀;特徵點提取模組,用於對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;面部狀態控制模組,用於根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

在上述基礎上,該發明實施例還提供了一種電子設備,包括存儲器、處理器和存儲於該存儲器並能夠在該處理器上運行的電腦程式,該電腦程式在該處理器上運行時實現上述的虛擬形象直播方法的步驟。在上述基礎上,該發明實施例還提供了一種計算機可讀存儲介質,其上存儲有電腦程式,該程式被執行時實現上述的虛擬形象直播方法的步驟。

改善效果

《虛擬形象直播方法、虛擬形象直播裝置和電子設備》在直播時基於主播的實時人臉圖像提取人臉特徵點進行計算後再對虛擬形象的面部狀態進行控制,一方面使得虛擬形象的面部狀態具有更好的靈動性,另一方面可以使得虛擬形象的面部狀態與主播的實際狀態具有較高的一致性,從而有效地提高直播的趣味性,進而提高用戶體驗度。

附圖說明

圖1為《虛擬形象直播方法、虛擬形象直播裝置和電子設備》實施例提供的直播系統的系統框圖。

圖2為該發明實施例提供的電子設備的方框示意圖。

圖3為該發明實施例提供的虛擬形象直播方法的流程示意圖。

圖4為圖3中步驟S150包括的子步驟的流程示意圖。

圖5為該發明實施例提供的對目標特徵點進行確定的流程示意圖。

圖6為該發明實施例提供的人臉特徵點的示意圖。

圖7為該發明實施例提供的人臉特徵點的另一示意圖。

圖8為該發明實施例提供的虛擬形象直播裝置包括的功能模組的方框示意圖。

圖示:10-電子設備;12-存儲器;14-處理器;20-第一終端;30-第二終端;40-後台伺服器;100-虛擬形象直播裝置;110-視頻幀獲取模組;130-特徵點提取模組;150-面部狀態控制模組。

權利權利

1.一種虛擬形象直播方法,其特徵在於,套用於直播設備,用於對直播畫面中展示的虛擬形象進行控制,所述方法包括:通過圖像獲取設備獲取主播的視頻幀;對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

2.根據權利要求1所述的方法,其特徵在於,所述根據所述多個人臉特徵點以及針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制的步驟,包括:根據所述多個人臉特徵點得到主播的當前面部信息;根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型;以及根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。

3.根據權利要求2所述的虛擬形象直播方法,其特徵在於,所述根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型的步驟,具體為:將所述當前面部信息與針對所述虛擬形象預先構建的多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述當前面部信息對應的目標面部模型。

4.根據權利要求1-3任意一項所述的虛擬形象直播方法,其特徵在於,還包括:對執行所述特徵提取處理時需要提取的目標特徵點進行確定。

5.根據權利要求4所述的虛擬形象直播方法,其特徵在於,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像;按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點;針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值;將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。

6.根據權利要求4所述的虛擬形象直播方法,其特徵在於,所述對執行所述特徵提取處理時需要提取的目標特徵點進行確定的步驟,包括:根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。

7.根據權利要求1-3任意一項所述的虛擬形象直播方法,其特徵在於,所述人臉圖像為深度圖像,該深度圖像具有各所述人臉特徵點的位置信息和深度信息。

8.一種虛擬形象直播裝置,其特徵在於,套用於直播設備,用於對直播畫面中展示的虛擬形象進行控制,所述裝置包括:視頻幀獲取模組,用於通過圖像獲取設備獲取主播的視頻幀;特徵點提取模組,用於對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點;面部狀態控制模組,用於根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

9.一種電子設備,其特徵在於,包括存儲器、處理器和存儲於該存儲器並能夠在該處理器上運行的電腦程式,該電腦程式在該處理器上運行時實現權利要求1-7任意一項所述虛擬形象直播方法的步驟。

10.一種計算機可讀存儲介質,其上存儲有電腦程式,其特徵在於,該程式被執行時實現權利要求1-7任意一項所述虛擬形象直播方法的步驟。

實施方式

如圖1所示,《虛擬形象直播方法、虛擬形象直播裝置和電子設備》實施例提供了一種直播系統,該直播系統可以包括第一終端20、第二終端30和與該第一終端20和該第二終端30分別通信連線的後台伺服器40。其中,所述第一終端20可以為主播在直播時使用的終端設備(如手機、平板電腦、電腦等),所述第二終端30可以為觀眾在觀看直播時使用的終端設備(如手機、平板電腦、電腦等)。

結合圖2,該發明實施例還提供了一種電子設備10。其中,該電子設備10可以作為一種直播設備,例如,可以是主播在直播時使用的終端設備(如上述的第一終端20),也可以是與主播在直播時使用終端設備通信連線的伺服器(如上述的後台伺服器40)。

詳細地,所述電子設備10可以包括存儲器12、處理器14和虛擬形象直播裝置100。所述存儲器12和處理器14之間直接或間接地電性連線,以實現數據的傳輸或互動。例如,相互之間可通過一條或多條通訊匯流排或信號線實現電性連線。所述虛擬形象直播裝置100包括至少一個可以軟體或固件(firmware)的形式存儲於所述存儲器12中的軟體功能模組。所述處理器14用於執行所述存儲器12中存儲的可執行的電腦程式,例如,所述虛擬形象直播裝置100所包括的軟體功能模組及電腦程式等,以實現虛擬形象直播方法,進而保證基於該虛擬形象直播方法進行直播時,虛擬形象的面部狀態具有更好的靈動性,以提高直播的趣味性,進而提高用戶體驗度。

其中,所述存儲器12可以是,但不限於,隨機存取存儲器(Random Access Memory,RAM),唯讀存儲器(Read Only Memory,ROM),可程式唯讀存儲器(Programmable Read-Only Memory,PROM),可擦除唯讀存儲器(Erasable Programmable Read-Only Memory,EPROM),電可擦除唯讀存儲器(Electric Erasable Programmable Read-Only Memory,EEPROM)等。其中,存儲器12用於存儲程式,所述處理器14在接收到執行指令後,執行所述程式。

所述處理器14可能是一種積體電路晶片,具有信號的處理能力。例如,可以是中央處理器(Central Processing Unit,CPU)、網路處理器(Network Processor,NP)、片上系統(System on Chip,SoC)、數位訊號處理器(DSP)等,以實現或者執行該發明實施例中的公開的各方法、步驟。

可以理解,圖2所示的結構僅為示意,所述電子設備10還可包括比圖2中所示更多或者更少的組件,或者具有與圖2所示不同的配置,例如,還可以包括用於與其它直播設備進行信息互動的通信單元。其中,圖2中所示的各組件可以採用硬體、軟體或其組合實現。

結合圖3,該發明實施例還提供一種可套用於上述電子設備10的虛擬形象直播方法,用於對直播畫面中展示的虛擬形象進行控制。其中,所述虛擬形象直播方法有關的流程所定義的方法步驟可以由所述電子設備10實現。下面將對圖3所示的具體流程進行詳細闡述。

步驟S110,通過圖像獲取設備獲取主播的視頻幀。

步驟S130,對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點。

步驟S150,根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。

詳細地,在步驟S110中,主播開始直播時,所述圖像獲取設備(如攝像頭)可以實時採集主播的圖像,以形成視頻並傳輸至連線的終端設備。其中,在一種示例中,若執行所述虛擬形象直播方法的電子設備10為所述終端設備時,該終端設備可以對該視頻進行處理,得到對應的視頻幀。在另一種示例中,若執行所述虛擬形象直播方法的電子設備10為後台伺服器40,所述終端設備可以將視頻傳送至該後台伺服器40,以使該後台伺服器40對該視頻進行處理,得到對應的視頻幀。

在該實施例中,通過步驟S110獲取到主播的視頻幀之後,由於該視頻幀可能是包括主播身體的任何一個部位或多個部位的一張圖片,且該張圖片中既可能包括主播的臉部信息,也可能不包括主播的臉部信息(如背影圖)。因此,在得到所述視頻幀之後,可以對該視頻幀進行人臉識別,以判斷該視頻幀中是否具有主播的臉部信息。然後,在判斷出所述視頻幀中具有主播的臉部信息時,也就是在該視頻幀中識別到人臉圖像時,再進一步對該人臉圖像進行特徵提取處理,以得到多個人臉特徵點。其中,所述人臉特徵點可以是,臉部具有較高標識性的特徵點,例如,可以包括,但不限於,嘴唇、鼻子、眼睛和眉毛等部位的特徵點。

在該實施例中,通過步驟S130得到主播的多個人臉特徵點之後,可以在多個面部模型中確定與該多個人臉特徵點對應的目標面部模型,並根據該面部模型的虛擬形象的面部狀態進行控制。其中,所述多個面部模型為針對所述虛擬形象預先進行構建的,並且,針對不同的面部狀態分別構建20、50、70、100或其它數量的面部模型,例如,可以包括,但不限於張嘴狀態的模型、閉嘴狀態的模型、閉眼狀態的模型、睜眼狀態的模型、大笑狀態的模型、悲傷狀態的模型、生氣狀態的模型等。

通過上述方法,可以在直播時根據主播的面部狀態對虛擬形象的面部狀態進行同步控制,使得虛擬形象的面部狀態能夠在較大程度上反映主播的面部狀態,進而保證虛擬形象的面部狀態能夠與主播輸出的語音或文字內容具有較高的一致性,以提高用戶的體驗。例如,在主播比較疲倦的時候,主播表示“想休息了”,眼睛的張開程度一般較小,此時,若虛擬形象的眼睛的張開程度還比較大,就會導致用戶的體驗度下降的問題。並且,主播在直播時面部狀態一般會發生較多的變化,因此,基於主播的面部狀態對虛擬形象的面部狀態進行控制,可以使虛擬形象的面部狀態具有多樣性,從而使得虛擬形象更加靈動,進而提高直播的趣味性。

可選地,步驟S110獲取的視頻幀既可以是二維的,也可以是三維的。相應地,所述圖像獲取設備既可以是普通攝像機,也可以是深度攝像機。其中,在所述圖像獲取設備為深度攝像機時,所述人臉圖像中為深度圖像,該深度圖像具有各所述人臉特徵點的位置信息和深度信息。因此,在基於該人臉特徵點進行處理時,可以基於該位置信息確定人臉特徵點的二維平面坐標,然後,再結合對應的深度信息將該二維平面坐標轉換為三維空間坐標。可選地,執行步驟S150的具體方式不受限制,可以根據實際套用需求進行選擇。例如,在一種可以替代的示例中,結合圖4,步驟S150可以包括步驟S151、步驟S153和步驟S155,具體內容如下所述。

步驟S151,根據所述多個人臉特徵點得到主播的當前面部信息。在該實施例中,所述面部信息的具體內容不受限制,並且,基於內容的不同,根據人臉特徵點得到面部信息的方式也可以不同。例如,在一種可以替代的示例中,可以基於所述多個人臉特徵點進行表情分析,以得到主播當前的面部表情(如微笑、大笑等)。也就是說,所述面部信息可以是指主播的面部表情。又例如,在另一種可以替代的示例中,可以基於各人臉特徵點之間的相對位置關係和確定的坐標系,得到各人臉特徵點的位置信息或坐標信息。也就是說,所述面部信息可以是指各人臉特徵點的位置信息或坐標信息。

步驟S153,根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型。在該實施例中,通過步驟S151得到主播的當前面部信息之後,可以在預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型。其中,在所述多個面部模型中獲取與該當前面部信息對應的目標面部模型的具體方式不受限制,例如,根據所述面部信息的內容不同,獲取的方式可以不同。

詳細地,在一種可以替代的示例中,若所述面部信息為主播的面部表情,可以基於預先確定的對應關係在多個面部模型中獲取與該當前面部信息對應的目標面部模型。其中,所述對應關係可以如下表所示:

面部表情1(如微笑) | 面部模型A |

面部表情2(如大笑) | 面部模型B |

面部表情3(如皺眉) | 面部模型C |

面部表情4(如怒目) | 面部模型D |

又例如,在另一種可以替代的示例中,所述面部信息可以是指各人臉特徵點的坐標信息,可以將所述坐標信息與所述多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述坐標信息對應的目標面部模型。詳細地,可以基於坐標信息將各人臉特徵點和面部模型中的各特徵點進行相似度計算,並將相似度最大的面部模型確定為目標面部模型。例如,若與面部模型A的相似度為80%,與面部模型B的相似度為77%,與面部模型C的相似度為70%,與面部模型D的相似度為65%,那么,可以將面部模型A確定為目標面部模型。採用這種相似度計算,相較於單純的面部表情匹配的方式,主播人臉與所述面部模型的匹配精確度更高,相應地,虛擬形象展示出來的內容則更貼合主播的當前狀態,實現更為逼真的直播,互動效果更好。需要說明的是,若執行步驟S153的設備為終端設備,在執行步驟S153時,該終端設備可以從通信連線的後台伺服器40中調取所述多個面部模型。

步驟S155,根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。在該實施例中,通過步驟S153確定目標面部模型之後,可以基於該目標面部模型對虛擬形象的面部狀態進行控制。例如,可以基於該目標面部模型對虛擬形象的面部圖像進行渲染,從而實現對面部狀態的控制。

進一步地,在該實施例中,在執行步驟S130之前,還可以對執行步驟S130時需要提取的人臉特徵點進行確定。也就是說,所述虛擬形象直播方法還可以包括以下步驟:對執行所述特徵提取處理時需要提取的目標特徵點進行確定。其中,對所述目標特徵點進行確定的方式不受限制,可以根據實際套用需求進行選擇。例如,在一種可以替代的示例中,結合圖5,進行目標特徵點確定的步驟可以包括步驟S171、步驟S173、步驟S175和步驟S177,具體內容如下所述。

步驟S171,獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像。在該實施例中,可以先獲取主播在不同面部狀態下的多個面部圖像。例如,可以是針對每一種面部狀態獲取一個面部圖像,如正常狀態(無表情)下的一個面部圖像、微笑狀態下的一個面部圖像、大笑狀態下的一個面部圖像、皺眉狀態下的一個面部圖像、怒目狀態下的一個面部圖像等按照需要預先獲取的多張面部圖像。

其中,在得到多個面部圖像之後,可以在其中選擇一個面部圖像作為參考圖像,例如,可以將正常狀態下的面部圖像作為參考圖像,例如,所述正常狀態下的一個面部圖像。需要說明的是,為了保證對目標特徵點進行確定具有較高的準確性,所述多個面部圖像可以是基於主播的同一個角度拍攝的多張圖像,例如,可以都是攝像頭正對主播臉部時拍攝的圖像。

步驟S173,按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點。在該實施例中,通過步驟S171得到多個面部圖像之後,可以針對每個面部圖像,在該面部圖像中提取預設數量個(如200個或240個)人臉特徵點。

步驟S175,針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值。在該實施例中,通過步驟S173得到每個面部圖像的人臉特徵點之後,可以針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值。

例如,可以將面部圖像A中的240個人臉特徵點與參考圖像中的240個人臉特徵點分別進行對比,以得到240個人臉特徵點在面部圖像A與參考圖像之間的變化值(可以是坐標之間的差值)。需要說明的是,考慮到節約處理器資源的問題,在進行人臉特徵點對比時,作為參考圖像的面部圖像可以不與該參考圖像進行對比(同一圖像,變化值為零)。

步驟S177,將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。在該實施例中,通過步驟S175得到各人臉特徵點在不同圖像中的變化值之後,可以基於該變化值與預設閾值進行比較,並將變化值大於預設閾值的人臉特徵點作為目標特徵點。

詳細地,例如,針對主播的左嘴角特徵點,在參考圖像中該特徵點的坐標為(0,0),在面部圖像A中該特徵點的坐標為(1,0),在面部圖像B中該特徵點的坐標為(2,0),通過步驟S175可以得到左嘴角特徵點對應的兩個變化值1和2,那么,只要這兩個變化值中最小的一個變化值小於預設閾值(如0.5),就可以將該左嘴角特徵點作為一個目標特徵點。

通過上述方法,一方面,可以在保證確定的目標特徵點能夠有效地反映主播的面部狀態;另一方面,還可以避免由於確定的目標特徵點太多而導致在直播時電子設備10的計算量過大,進而導致直播的實時性較差或對電子設備10的性能要求過高的問題。如此,在步驟S173進行人臉特徵點提取時,可只需要針對確定的目標特徵點進行提取用於後續的計算,減少直播時的實時計算量,提升直播的流暢度。

需要說明的是,所述預設閾值的具體數值可以綜合考慮電子設備10的性能、實時性需求以及面部狀態控制的精度等因素進行確定。例如,在對面部狀態的控制需要較高的精度時,可以設定一個較小的預設閾值,以使確定的目標特徵點的數量較多(如圖6所示,鼻子和嘴巴對應的特徵點較多)。又例如,在對實時性需要較高時,可以設定一個較大的預設閾值,以使確定的目標特徵點的數量較少(如圖7所示,鼻子和嘴巴對應的特徵點較少)。

進一步地,該發明實施例還提供了一種對所述目標特徵點進行確定的方法。詳細地,該方法可以包括以下步驟:根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。其中,所述歷史直播數據的具體內容不受限制,例如,可以包括,但不限於收到的禮物的數量、直播的時長、彈幕的數量和主播的等級等參數中的至少一種。例如,若主播的等級越高,所述目標特徵點的數量可以越多。對應地,在該主播進行直播時,在直播畫面中展示的虛擬形象的面部狀態的控制精度也就越高,觀眾的體驗也會越高。

結合圖8,該發明實施例還提供一種可套用於上述電子設備10的虛擬形象直播裝置100,用於對直播畫面中展示的虛擬形象進行控制。其中,所述虛擬形象直播裝置100可以包括視頻幀獲取模組110、特徵點提取模組130和面部狀態控制模組150。所述視頻幀獲取模組110,用於通過圖像獲取設備獲取主播的視頻幀。在該實施例中,所述視頻幀獲取模組110可用於執行圖3所示的步驟S110,關於所述視頻幀獲取模組110的相關內容可以參照前文對步驟S110的描述。所述特徵點提取模組130,用於對所述視頻幀進行人臉識別,並在所述視頻幀中識別到人臉圖像時,對該人臉圖像進行特徵提取處理,得到多個人臉特徵點。在該實施例中,所述特徵點提取模組130可用於執行圖3所示的步驟S130,關於所述特徵點提取模組130的相關內容可以參照前文對步驟S130的描述。

所述面部狀態控制模組150,用於根據所述多個人臉特徵點和針對所述虛擬形象預先構建的多個面部模型對所述虛擬形象的面部狀態進行控制。在該實施例中,所述面部狀態控制模組150可用於執行圖3所示的步驟S150,關於所述面部狀態控制模組150的相關內容可以參照前文對步驟S150的描述。其中,所述面部狀態控制模組150可以包括面部信息獲得子模組、面部模型獲取子模組和面部狀態控制子模組。

所述面部信息獲得子模組,用於根據所述多個人臉特徵點得到主播的當前面部信息。在該實施例中,所述面部信息獲得子模組可用於執行圖4所示的步驟S151,關於所述面部信息獲得子模組的相關內容可以參照前文對步驟S151的描述。所述面部模型獲取子模組,用於根據所述當前面部信息從針對所述虛擬形象預先構建的多個面部模型中獲取與該當前面部信息對應的目標面部模型。在該實施例中,所述面部模型獲取子模組可用於執行圖4所示的步驟S153,關於所述面部模型獲取子模組的相關內容可以參照前文對步驟S153的描述。

所述面部狀態控制子模組,用於根據所述目標面部模型對所述虛擬形象的面部狀態進行控制。在該實施例中,所述面部狀態控制子模組可用於執行圖4所示的步驟S155,關於所述面部狀態控制子模組的相關內容可以參照前文對步驟S155的描述。詳細地,所述面部模型獲取子模組具體用於:將所述當前面部信息與針對所述虛擬形象預先構建的多個面部模型分別進行匹配度計算,並將匹配度滿足預設條件的面部模型確定為所述當前面部信息對應的目標面部模型。

進一步地,所述虛擬形象直播裝置100還可以包括特徵點確定模組。其中,所述特徵點確定模組,用於對執行所述特徵提取處理時需要提取的目標特徵點進行確定。其中,在一種可以替代的示例中,所述特徵點確定模組可以包括面部圖像獲取子模組、特徵點提取子模組、特徵點比較子模組和特徵點確定子模組。

所述面部圖像獲取子模組,用於獲取主播在不同面部狀態下的多個面部圖像,並選取其中一個作為參考圖像。在該實施例中,所述面部圖像獲取子模組可用於執行圖5所示的步驟S171,關於所述面部圖像獲取子模組的相關內容可以參照前文對步驟S171的描述。所述特徵點提取子模組,用於按照預設的特徵提取方法分別提取出每個所述面部圖像中包括的預設數量個人臉特徵點。在該實施例中,所述特徵點提取子模組可用於執行圖5所示的步驟S173,關於所述特徵點提取子模組的相關內容可以參照前文對步驟S173的描述。

所述特徵點比較子模組,用於針對每個面部圖像,將該面部圖像中提取出的各人臉特徵點與所述參考圖像中提取出的各人臉特徵點進行對比,得到該面部圖像中各人臉特徵點相對於所述參考圖像中各人臉特徵點的變化值。在該實施例中,所述特徵點比較子模組可用於執行圖5所示的步驟S175,關於所述特徵點比較子模組的相關內容可以參照前文對步驟S175的描述。所述特徵點確定子模組,用於將變化值大於預設閾值的人臉特徵點作為執行所述特徵提取處理時需要提取的目標特徵點。在該實施例中,所述特徵點確定子模組可用於執行圖5所示的步驟S177,關於所述特徵點確定子模組的相關內容可以參照前文對步驟S177的描述。

在另一種可以替代示例中,所述特徵點確定模組可以包括數量確定子模組。其中,所述數量確定子模組,用於根據主播的歷史直播數據確定執行所述特徵提取處理時需要提取的目標特徵點的數量。在該發明實施例中,對應於上述的虛擬形象直播方法,還提供了一種計算機可讀存儲介質,該計算機可讀存儲介質中存儲有電腦程式,該電腦程式運行時執行上述虛擬形象直播方法的各個步驟。其中,前述電腦程式運行時執行的各步驟,在此不再一一贅述,可參考前文對所述虛擬形象直播方法的解釋說明。

綜上所述,該發明提供的虛擬形象直播方法、虛擬形象直播裝置和電子設備,在直播時基於主播的實時人臉圖像提取人臉特徵點進行計算後再對虛擬形象的面部狀態進行控制,一方面使得虛擬形象的面部狀態具有更好的靈動性,另一方面可以使得虛擬形象的面部狀態與主播的實際狀態具有較高的一致性,從而有效地提高直播的趣味性,進而提高用戶體驗度。

在該發明實施例所提供的幾個實施例中,應該理解到,所揭露的裝置和方法,也可以通過其它的方式實現。以上所描述的裝置和方法實施例僅僅是示意性的,例如,附圖中的流程圖和框圖顯示了根據該發明的多個實施例的裝置、方法和電腦程式產品的可能實現的體系架構、功能和操作。在這點上,流程圖或框圖中的每個方框可以代表一個模組、程式段或代碼的一部分,所述模組、程式段或代碼的一部分包含一個或多個用於實現規定的邏輯功能的可執行指令。也應當注意,在有些作為替換的實現方式中,方框中所標註的功能也可以以不同於附圖中所標註的順序發生。例如,兩個連續的方框實際上可以基本並行地執行,它們有時也可以按相反的順序執行,這依所涉及的功能而定。也要注意的是,框圖和/或流程圖中的每個方框、以及框圖和/或流程圖中的方框的組合,可以用執行規定的功能或動作的專用的基於硬體的系統來實現,或者可以用專用硬體與計算機指令的組合來實現。另外,在該發明各個實施例中的各功能模組可以集成在一起形成一個獨立的部分,也可以是各個模組單獨存在,也可以兩個或兩個以上模組集成形成一個獨立的部分。

所述功能如果以軟體功能模組的形式實現並作為獨立的產品銷售或使用時,可以存儲在一個計算機可讀取存儲介質中。基於這樣的理解,該發明的技術方案本質上或者說對現2019年3月之前的技術做出貢獻的部分或者該技術方案的部分可以以軟體產品的形式體現出來,該計算機軟體產品存儲在一個存儲介質中,包括若干指令用以使得一台計算機設備(可以是個人計算機,電子設備,或者網路設備等)執行該發明各個實施例所述方法的全部或部分步驟。而前述的存儲介質包括:隨身碟、移動硬碟、唯讀存儲器(ROM,Read-Only Memory)、隨機存取存儲器(RAM,Random Access Memory)、磁碟或者光碟等各種可以存儲程式代碼的介質。

榮譽表彰

2021年11月,《虛擬形象直播方法、虛擬形象直播裝置和電子設備》獲得第八屆廣東專利獎優秀獎。