在神經網路中,當前面隱藏層的學習速率低於後面隱藏層的學習速率,即隨著隱藏層數目的增加,分類準確率反而下降了。這種現象叫做消失的梯度問題。

基本介紹

- 中文名:梯度消失問題

- 外文名: vanishing gradient problem

- 相關:梯度爆炸問題

簡介

產生原因

解決方案

在神經網路中,當前面隱藏層的學習速率低於後面隱藏層的學習速率,即隨著隱藏層數目的增加,分類準確率反而下降了。這種現象叫做消失的梯度問題。

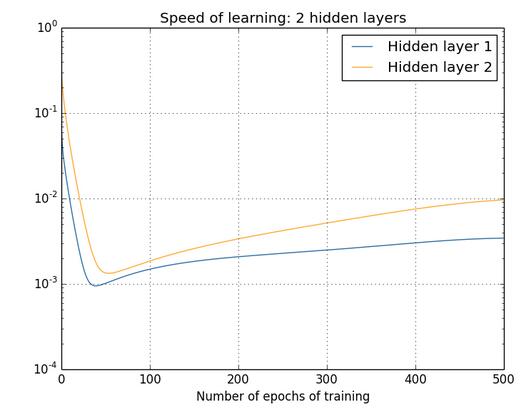

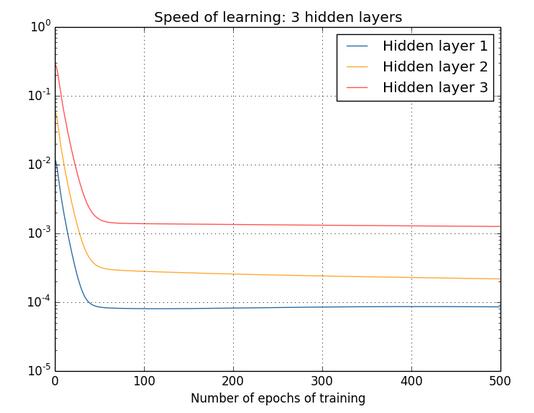

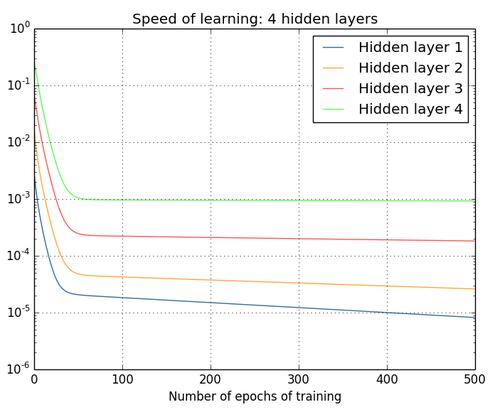

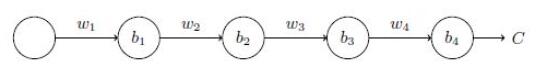

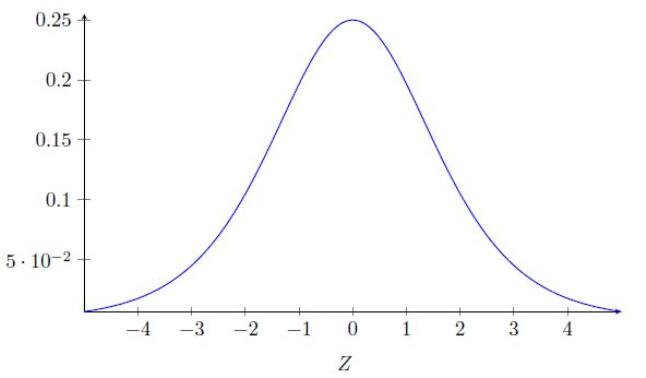

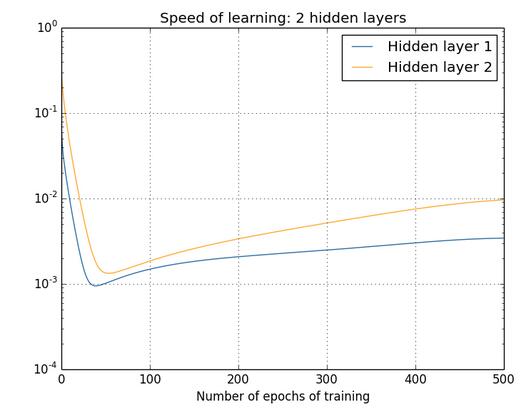

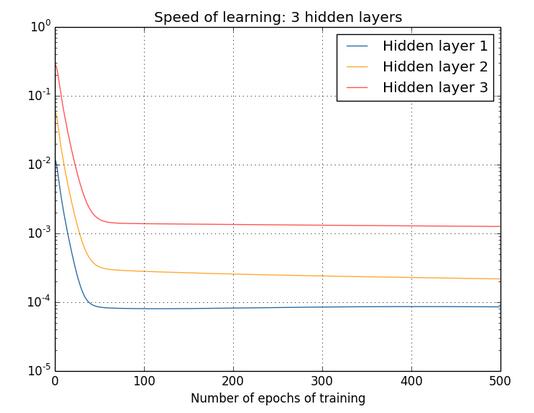

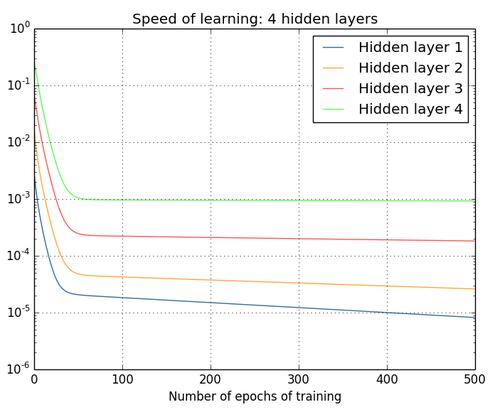

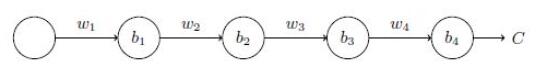

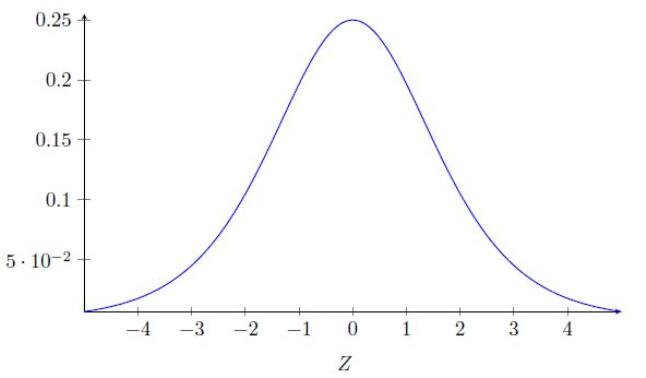

在神經網路中,當前面隱藏層的學習速率低於後面隱藏層的學習速率,即隨著隱藏層數目的增加,分類準確率反而下降了。這種現象叫做消失的梯度問題。簡介圖1是神經網路在訓練過程中, 隨epoch增加時各種隱藏層的學習率變化。兩個隱藏...

第1章 介紹深度學習的簡潔發展思路和表示學習機制; 第2章、第3章介紹神經網路的基於梯度的最佳化方法、神經網路的最佳化難點以及相應的解決方法; 第4章討論神經網路遇到的過擬合問題; 第5章分析神經網路的小組成部分——神經元; 第6章...

5.2 梯度消失的原因 168 5.2.1 為何出現梯度消失 170 5.2.2 梯度爆炸問題 171 5.2.3 梯度不穩定問題 172 5.2.4 梯度消失問題普遍存在 172 5.3 複雜神經網路中的梯度不穩定 173 5.4 深度學習的其他障礙 174 ...

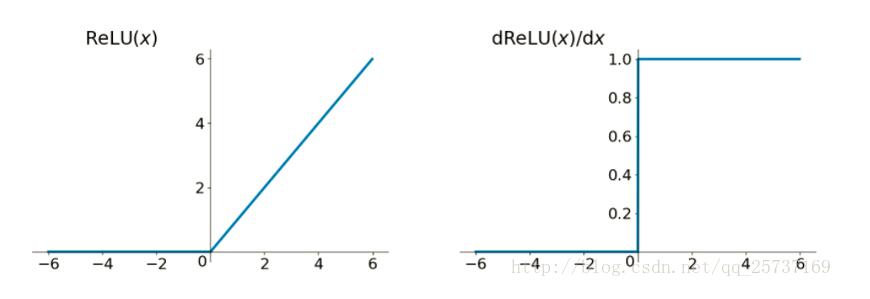

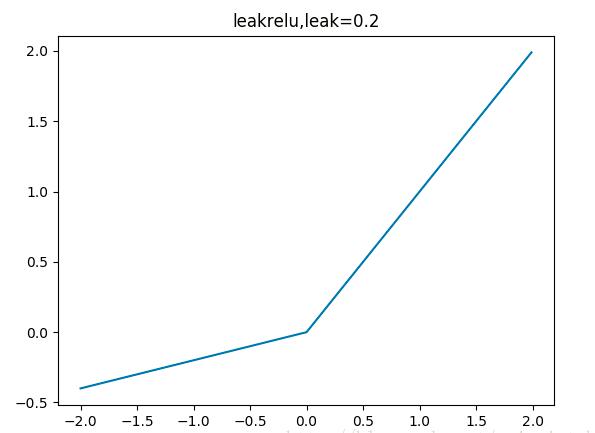

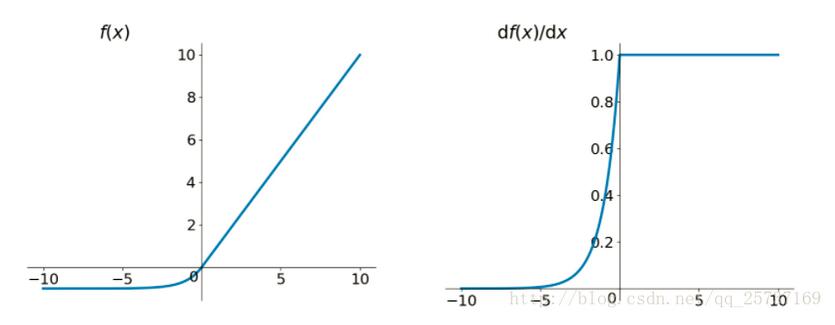

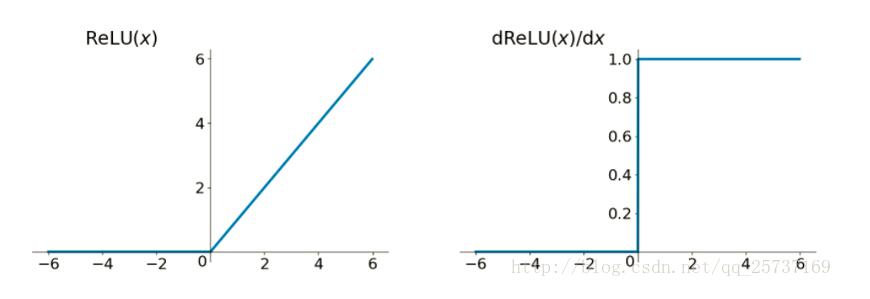

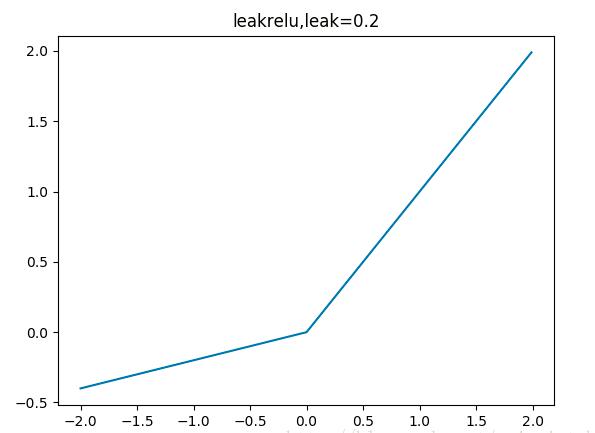

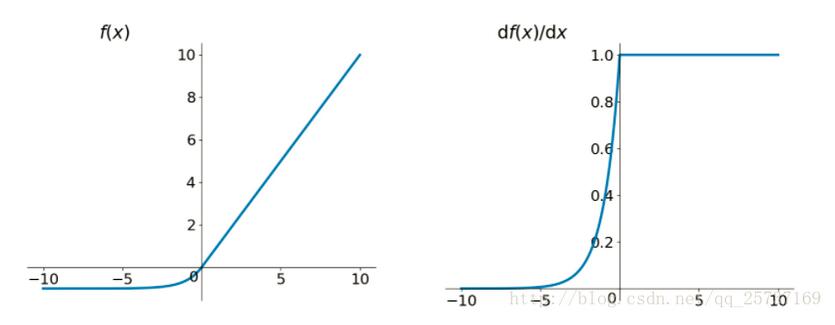

4.3.1 梯度消失問題 89 4.3.2 ReLU 的理論支撐. 92 4.3.3 ReLU 的線性性質. 93 4.3.4 ReLU 的不足. 93 4.4 總結. 94 4.5 參考文獻. 94 5 Caffe 入門95 5.1 使用Caffe 進行深度學習訓練. 96 5.1.1 數據預...

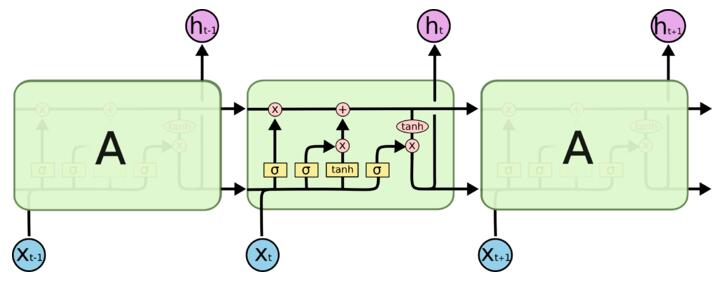

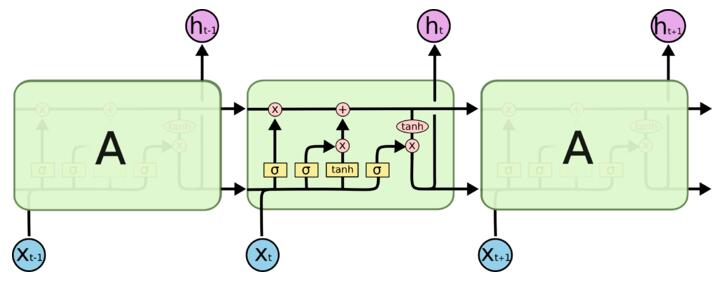

2. 詳細介紹RNNs中一些經常使用的訓練算法,如Back Propagation Through Time(BPTT)、Real-time Recurrent Learning(RTRL)、Extended Kalman Filter(EKF)等學習算法,以及梯度消失問題(vanishing gradient problem)3. 詳細介紹Long Short-Term...

8.3.2過擬合問題160 8.3.3局部極值問題162 8.3.4梯度消失問題163 8.4常用的深度神經網路166 8.4.1自編碼網路166 8.4.2深度玻爾茲曼機168 8.4.3深度信念網路169 8.4.4卷積神經網路170 8.4.5循環神經網路174 8.4.6...

首先提出了具有非對稱結構的AE(UnsymmetricAuto-Encoder, UAE)模型,較傳統的AE模型而言,所提出的UAE可以學習到更多更有效的物體特徵,更一步的我們分析了UAE模型的梯度消失問題。其次,我們在AE模型的代價函式中顯示地加入了一個具有引導...

即線性整流)的神經網路中大概有50%的神經元處於激活態。更加有效率的梯度下降以及反向傳播:避免了梯度爆炸和梯度消失問題。簡化計算過程:沒有了其他複雜激活函式中諸如指數函式的影響;同時活躍度的分散性使得神經網路整體計算成本下降。

6.3.1 問題描述 6.3.2 改進的HMM學習算法 6.4 循環神經網路及其最佳化 6.4.1 循環神經網路概述 6.4.2 循環神經網路模型結構 6.4.3 改進的循環神經網路 6.5 長短期記憶網路及其改進 6.5.1 RNN梯度消失問題 6....

4.8 梯度消失與梯度爆炸 67 4.8.1 梯度消失 67 4.8.2 梯度爆炸 69 4.8.3 使用ReLU函式解決梯度消失和梯度爆炸的問題 69 4.9 使用BP神經網路解決異或問題 70 4.10 分類模型評估方法 74 4.10.1 準確率/精確率/召回率/F1...

9.5面臨的問題111 9.5.1梯度消失111 9.5.2退化111 9.5.3局部極小值111 9.5.4鞍點111 9.6實現細節問題112 9.6.1輸入值與輸出值112 9.6.2網路規模112 9.6.3激活函式112 9.6.4損失函式113 9.6.5權重初始化113 9....

每種機制受損均有多種病因造成。最常見病因包括外傷、心博驟停、神經系統疾病、吸入異物、支氣管痙攣、藥物過量。病因 氣道梗阻 腦幹功能障礙 神經肌肉障礙 實質病變 胸膜壓力梯度消失 肺毛細血管灌注減少 ...

2.5 分離梯度下降法與參數最佳化策略 119 2.5.1 參數最佳化器 119 2.5.2 接受參數最佳化器的梯度下降法 120 第3章 線性回歸、邏輯回歸和softmax回歸 122 3.1 線性回歸 122 3.1.1 餐車利潤問題 122 3.1.2 機器學習與人工...

Inception結構的複雜性使它依然存在修改困難的問題。如果只是簡單的擴大結構規模,計算的優勢會馬上消失。並且不能清楚的描述GoogLeNet結構不同設計的考慮因素。這使它難以在維持效率的同時依據新情況更新。例如,如果需要提高一些Inception風格...

5.4 隨機梯度下降和線上學習 123 5.5 關於多個隱藏層的問題:梯度消失和梯度爆炸 124 第6章 卷積神經網路 127 6.1 第三次介紹邏輯回歸 127 6.2 特徵圖和池化 131 6.3 一個完整的卷積網路 133 6.4 使用卷積網路對文本進行分類 136 第...

11.4.1梯度下降法 11.4.2梯度消失及梯度爆炸 11.5卷積神經網路 11.5.1卷積 11.5.2池化 11.5.3網路架構 11.6循環神經網路 11.7生成對抗網路 11.8圖卷積神經網路 11.9深度學習發展 11.10實例: 基於卷積神經網路實現手寫...

5.1.4梯度消失和梯度爆炸76 5.2長短期記憶網路——LSTM78 5.2.1長期依賴問題78 5.2.2長短期記憶網路結構79 5.3綜合案例: 語義情感分析83 5.4本章小結88 思考題88 第7章基於深度學習的目標檢測99 7.1目標檢測基礎99 7.1....

11.4.1梯度下降法 11.4.2梯度消失及梯度爆炸 11.5卷積神經網路 11.5.1卷積 11.5.2池化 11.5.3網路架構 11.6循環神經網路 11.7生成對抗網路 11.8圖卷積神經網路 11.9深度學習發展 11.10實例: 基於卷積神經網路實現手寫...