遞歸網路是一種表示學習,它可以將詞、句、段、篇按照他們的語義映射到同一個向量空間中,也就是把可組合(樹/圖結構)的信息表示為一個個有意義的向量。

基本介紹

- 中文名:遞歸網路

- 套用領域:深度學習

遞歸網路是一種表示學習,它可以將詞、句、段、篇按照他們的語義映射到同一個向量空間中,也就是把可組合(樹/圖結構)的信息表示為一個個有意義的向量。

遞歸網路是一種表示學習,它可以將詞、句、段、篇按照他們的語義映射到同一個向量空間中,也就是把可組合(樹/圖結構)的信息表示為一個個有意義的向量。簡介遞歸神經網路將所有的詞、句都映射到一個2維向量空間中。句子(the co...

遞歸,網路流行語,來源於“遞歸”算法,表示不斷重複引用別人的話從而產生循環。詞語來源 在數學與計算機科學中,遞歸(Recursion)是指函式的自身調用。這個算法演變為了程式設計師之間的梗,所表達的意思近似於“套娃”,表示不斷重複引用別人...

遞歸神經網路(recursive neural network)是具有樹狀階層結構且網路節點按其連線順序對輸入信息進行遞歸的人工神經網路(Artificial Neural Network, ANN),是深度學習(deep learning)算法之一。遞歸神經網路(recursive neural network)提出於...

Hopfield神經網路是一種遞歸神經網路,由約翰·霍普菲爾德在1982年發明。Hopfield網路是一種結合存儲系統和二元系統的神經網路。它保證了向局部極小的收斂,但收斂到錯誤的局部極小值(local minimum),而非全局極小(global minimum)的情況...

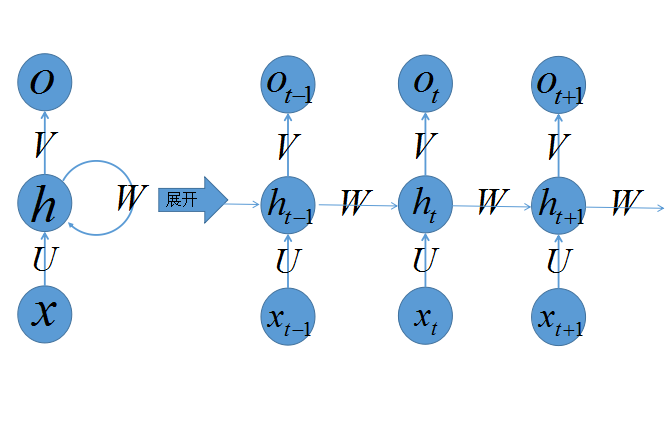

循環神經網路(Recurrent Neural Network, RNN)是一類以序列(sequence)數據為輸入,在序列的演進方向進行遞歸(recursion)且所有節點(循環單元)按鏈式連線的遞歸神經網路(recursive neural network)。對循環神經網路的研究始於二十世紀80-...

二進制遞歸網路(BRN)具有結構規則、易於分割等優點,是理論研究和實際套用中頗受歡迎的網路結構。現有的BRN容錯性研究成果大多基於故障數小於連通度、網路仍然連通的少故障假設,不能反映故障數大於連通度、網路不再連通的多故障模式下...

《立方形遞歸網路》是2002年大連海事學院出版社出版的圖書,作者是王德強。編輯推薦 本書以數學為基礎,系統研究互連網路,特別是超立方體網路的拓撲性質、網路參數、容錯性能、通信算法等。內容主要包括:互連網路的拓撲與互連函式,立方形...

《遞歸人工神經網路的定性分析和綜合》是2004年科學出版社出版的圖書,作者是劉德榮 / (美)A.N. 米歇爾。圖書簡介 sign函式做為激活函式的離散Hopfield神經網路;Sigmoid函式具有無限增益的模擬Hopfield神經網路;Grossberg模型及工作於閉超...

結合三維憶阻器和神經元模擬器構建憶阻遞歸網路的神經形態電路,突破傳統的電路結構,在同一電路上實現自聯想和異聯想記憶,並對理論分析結果加以驗證,研究成果可直接套用於構建基於憶阻器的電子大腦。結題摘要 類腦神經網路的實現需要結構...

遞歸轉移網路(RTN)是ATN的前身,RTN利用有限狀態機原理,把句子劃分成由若干種狀態和弧組成的狀態圖,每種狀態之間用弧來連線。其中有一個狀態需要被設定為初始狀態,在弧上不僅可以標以終結符號(即具體的詞,如“的”)和詞類符號(如...

《基於KKT條件的最佳化遞歸神經網路簇設計》是依託清華大學,由胡曉林擔任項目負責人的青年科學基金項目。項目摘要 本課題將針對各種最佳化及相關問題設計基於Karush-Kuhn-Tucker(KKT)條件的遞歸神經網路簇進行求解。其主要思想是固定已有網路的...

模擬人類實際神經網路的數學方法問世以來,人們已慢慢習慣了把這種人工神經網路直接稱為神經網路。神經網路在系統辨識、模式識別、智慧型控制等領域有著廣泛而吸引人的前景,特別在智慧型控制中,人們對神經網路的自學習功能尤其感興趣,並且把神經...

ESN是Jaeger於2001年提出一種新型遞歸神經網路,ESN一經提出便成為學術界的熱點,並被大量地套用到各種不同的領域中,包括動態模式分類、機器人控制、對象跟蹤核運動目標檢測、事件監測等,尤其是在時間序列預測問題上,取得了較為突出的...

互遞歸是數學與計算機科學中一種遞歸,指兩個數學或計算機對象如函式或數據類型互相定義。互遞歸在函式程式語言或某些問題域中非常常見,如遞歸下降分析器,其中數據類型是自然地互相遞歸定義的。例子 數據類型 採取互遞歸定義的最重要的基本...

2016年6月,在倫敦科幻電影節上,由紐約大學AI研究人員開發的遞歸神經網路“班傑明(Benjamin)”寫出了一部科幻電影,成為本屆電影節48小時電影製作挑戰賽的參賽作品之一。簡介 “班傑明(Benjamin)”,由紐約大學AI研究人員開發的遞歸神經...

概述圖中給出分析句子、名詞短語、前置詞短語的三個遞歸轉移網路,其中每個網路的起始節點標號代表這網路所要分析的語法類,實際上這個標號也代表語法分析程式的名稱。每條有向弧線上的標號可以是詞或詞組。帶雙圈的節點代表接收狀態。如果...

6DNS系統是面向企業和運營商的DNS遞歸服務系統IPv6升級整體解決方案,由下一代網際網路國家工程中心發布,旨在打通IPv6網路與套用的關鍵一環,提供安全可靠、敏捷易操作的遞歸服務,助力中國《推進網際網路協定第六版(IPv6)規模部署行動計畫...

NeuroSolutions 是由具有世界領先科技的NeuroDimension開發的一個頂級水平的人工神經網路集成開發環境。簡介 NeuroSolutions是由具有世界領先科技的NeuroDimension開發的一個頂級水平的人工神經網路集成開發環境。它把模組化,組件為基礎的神經網路...

同時在缺失若干幀畫面的情況下也能獲得很好的實驗結果。受此啟發的深度注意力遞歸Q網路(deep attentionrecurrent Q network, DARQN)。它能夠選擇性地重點關注相關信息區域,減少深度神經網路的參數數量和計算開銷。

遞歸神經網路 / 87 5.1 遞歸神經網路套用背景介紹 / 88 5.2 遞歸神經網路模型介紹 / 89 5.2.1 遞歸神經網路模型結構 / 89 5.2.2 雙向遞歸神經網路 / 90 5.2.3 長短期記憶模型 / 91 5.3 遞歸神經網路展望 / 94 5.4...