指數線性單元,該激活函式由Djork等人提出,被證實有較高的噪聲魯棒性,同時能夠使得使得神經元的平均激活均值趨近為 0,同時對噪聲更具有魯棒性。由於需要計算指數,計算量較大。

基本介紹

- 中文名:指數線性單元

- 外文名:exponential linear unit

- 相似激活函式:Leaky ReLU、SELU

簡介,表達式,與其他激勵函式對比圖像,類似激活函式,ReLU,Leaky ReLU,SELU,

簡介

表達式

與其他激勵函式對比圖像

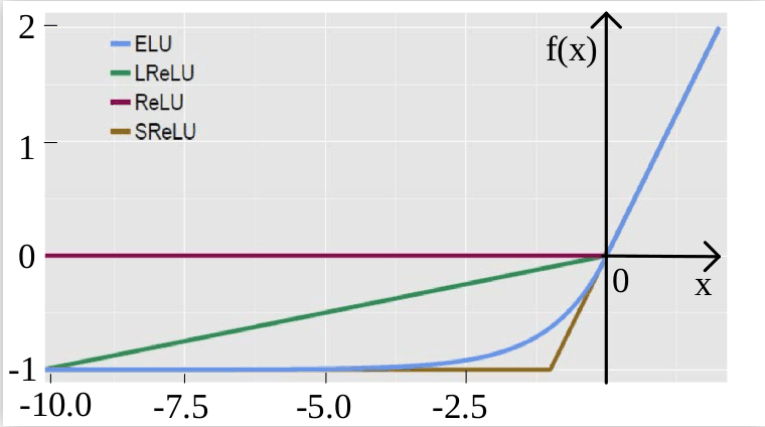

ELU與其他類似激活函式對比

ELU與其他類似激活函式對比上圖為ELU、LReLU、ReLU和SReLU的對比圖。

類似激活函式

神經網路中使用激活函式來加入非線性因素,提高模型的表達能力。Leaky ReLU、ELU及SELU均為ReLU的變種函式。

ReLU

Rectified Linear Unit,修正線性單元,形式如下:

softplus函式 與ReLU函式接近,但比較平滑,同ReLU一樣是單邊抑制,有寬廣的接受域(0,+inf), 但是由於指數運算,對數運算計算量大的原因,而不太被人使用。

與ReLU函式接近,但比較平滑,同ReLU一樣是單邊抑制,有寬廣的接受域(0,+inf), 但是由於指數運算,對數運算計算量大的原因,而不太被人使用。

ReLU的缺點:

1.壞死: ReLU 強制的稀疏處理會減少模型的有效容量(即特徵禁止太多,導致模型無法學習到有效特徵)。由於ReLU在x < 0時梯度為0,這樣就導致負的梯度在這個ReLU被置零,而且這個神經元有可能再也不會被任何數據激活,稱為神經元“壞死”。

2.無負值: ReLU和sigmoid的一個相同點是結果是正值,沒有負值。

Leaky ReLU

當 時,

時, ,其中

,其中 非常小,這樣可以避免在

非常小,這樣可以避免在 時,不能夠學習的情況:

時,不能夠學習的情況:

當 從高斯分布中隨機產生時稱為Random Rectifier(RReLU);

從高斯分布中隨機產生時稱為Random Rectifier(RReLU);

當 時,稱為Leaky ReLU。

時,稱為Leaky ReLU。

優點:1.不會過擬合;2.計算簡單有效;3.收斂更快。

SELU

SELU是給ELU乘上係數 ,即:

,即: