基本介紹

- 中文名:YARN

- 外文名:YARN

- 類型:Hadoop 資源管理器

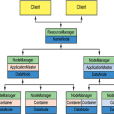

YARN的基本思想是將JobTracker的兩個主要功能(資源管理和作業調度/監控)分離,主要方法是創建一個全局的ResourceManager(RM)和若干個針對應用程式的ApplicationMaster(AM)。這裡的應用程式是指傳統的MapReduce作業或作業的DAG(有向無環圖...

《Hadoop YARN權威指南》是2015年4月機械工業出版社出版的圖書,作者是(美) Arun C Murthy、(美)Vinod KumarVavilapalli、(美) Jeff Markham。內容簡介 《Hadoop YARN指南》由YARN的創建和開發團隊親筆撰寫,Altiscale的CEO作序鼎力推薦...

《Hadoop 2.0-YARN核心技術實踐》是2015年9月1日出版的圖書,作者是周維。內容簡介 本書基於長期的教學實踐以及同國內外頂尖公司的交流合作編寫完成,系統介紹了Hadoop2.0-YARN的基本概念與運行模式。全書共分為7章。內容涵蓋Hadoop 2....

YARN DYE SS TEE 夏季運動短袖T恤是愛迪達品牌旗下的一款產品。中文名 YARN DYE SS TEE 夏季運動短袖T恤 所屬品牌 愛迪達 顏色 藏青/藍/鮮紅 類型 服裝類 目錄 1產品簡介 2產品參數

《白色情人》是一部小說,作者是yarn2009,連載於紅袖添香網。內容簡介 《白色qíng人》講了三個不同性格不同背景的女孩生活狀態,我用了很平淡的語氣描述著他們的故事。也許故事是出乎意料的精彩,也許故事是超出了你所看到的生活,但是我...

Cockled Yarn是織物疵點專用術語。(Cockled Yarn) -織物疵點專用術語,中文譯名為“扭結紗疵”。這種情況指的是,某根紗線中的一些纖維看起來顯得很捲曲而且分不清纖維的方向。產生這種情況的原因是由於一些紗線纖維相對於繪圖輥來說太長...

yarnsmith,英語單詞,主要用作為名詞,意為“作家”。雙語例句 The Chinese modern literature before the new period became break the ranks cause the mortification literature policy and yarnsmith's sequacious craze.新時期以前的中國...

紗[線]紗[線](yarn)是2016年公布的化學名詞。定義 將許多短纖維或長絲排列成近似平行狀態,並沿軸向旋轉加捻,組成的具有一定強度和線密度的細長絲束的通稱。出處 《化學名詞》 (第二版)

變形紗(textured[filament] yarn)指的是具有(或潛在地具有)捲曲、螺旋、環圈等外觀特性而呈現膨鬆性、伸縮性的單根或多根長絲紗。化學原絲在熱和機械作用下,經過變形加工使之具有捲曲、螺旋、環圈等外觀特性而呈現蓬鬆性、伸縮性的...

『Final Yard』是Yarn的獨立原創品牌,現有成員:FinalYard 過去現在未來 靜靜呼吸時間暫停 小狗一樣的鼻子 嗅到了兒時那支雲朵般的棉花糖 輕輕閉上的眼睛 看到了童年那匹搖啊搖的小木馬 用力張開的雙臂 擁抱住了自由的風 設計師:刀...

FDY,FULLY DRAWN YARN,全拉伸絲 (台灣稱全延伸絲),在紡絲過程中引入拉伸作用,可獲得具有高取向度和中等結晶度的卷繞絲,為全拉伸絲。常規的有滌綸和錦綸的全拉伸絲,都屬於化纖長絲。FDY面料手感順滑柔軟,經常被用於織造仿真絲...

雙收縮絲: (BI-SHRINKAGE YARN) ( B S Y ) 由不同收縮性能之兩根長絲在紡絲或後加工過程中紡製成。雙組分絲: (B1-COMPONTENT YARN) (B C Y) 由橫截面內含有不同收縮性的兩種組分的長絲製成的纖維。(2) 假編變形絲 (...

拉絲級聚丙烯(PP YARN)指的是融流指數在2-5左右的均聚聚丙烯原料,可用來拉絲的原料。主要用途是做太空袋,編織袋,文具片材,漁網等。石化廠都有此類原料。例如:印度H030SG,中石油T30S,天津聯合504PT,沙特的1102K等都是此規格原料...

基礎篇詳細介紹了Hadoop、YARN、MapReduce、HDFS、Hive、Sqoop和HBase,並深入探討了Hadoop的運維和調優;套用篇則包含了一個具有代表性的完整的基於Hadoop的商業智慧型系統的設計和實現;結束篇對全書進行總結,並對技術發展做了展望。圖書...

11資源管理和調度框架——YARN(180)11.1MRv1架構面臨的問題(180)11.2YARN架構(181)11.2.1YARN整體架構(181)11.2.2RM組件的作用(183)11.2.3AM組件的作用(184)11.2.4NM組件的作用(185)11.2.5運行在YARN上的計算框架(186)1...

the number of yarn in Nm the base /woof :50/1 每條基緯線的紗線數:50/1 --- cutting force 20*5 bade woof:800/400 刻紋力20*5 緯線:800/400 --- cutting streching in % baes /woof:12,0/13,0 每緯線的刻紋...

第4章YARN的原理和操作 4.1YARN簡介 4.1.1YARN的概念及背景 4.1.2YARN的使用 4.1.3YARN介紹 4.2YARN的基本架構 4.3YARN的工作流程 4.4YARN協定 4.5YARN的優點 第5章MapReduce的介紹和簡單使用 5.1MapReduce簡介...

3 The Yarn Quality紗的質量 3.1 Yarn Linear Density紗的線密度 3.1.1 Weight Based System定長制 3.1.2 Length Based System定重製 3.2 Yarn Twist紗的捻度 3.3 Yarn Strength and Elongation紗的強度和伸長 CHAPTER 3 ...

抗起毛起球性:pillingresistance 耐磨性:abrasionresistance 拒水性:waterrepellency 抗水性:waterresistance 織物密度:threadperinch/stichdensity 紗支:yarncount 克重:weight FABRICDEFECTS布疵 COLORYARN色紗 THICKYARN粗紗 DRAWYARN抽紗 ...

一種非傳統紡紗方法。(siroyarn類同)將兩根纖維條經牽伸裝置拉細,由前羅拉、搓捻輥輸出,在導紗鉤處合。搓捻輥除迴轉外,並快速軸嚮往復運動,搓轉紗條,使搓捻輥前後的紗條獲得方向相反的捻回。在導紗鉤處合後的兩根紗條,...

《精通Hadoop 3》是2022年一本清華大學出版社出版的圖書,作者是尚沙勒·辛格[印]等著,張華臻譯。內容簡介 《精通Hadoop3》詳細闡述了與Hadoop 3相關的基礎知識,主要包括Hadoop 3簡介、深入理解Hadoop分散式檔案系統、YARN資源管理器、...

bunchy yarn 竹節紗 ; 雪花線 ; 軋光整理壓光裝飾 ; 竹結紗 bunchy segregation 葡萄狀分凝 bunchy reef 束狀脈 bunchy top 束頂 bunchy connection 束狀聯接 Banana Bunchy Top VirusBBTV 香蕉束頂病毒 Banana Bunchy top vires...

《精通Hadoop》是2016年人民郵電出版社出版的圖書,作者是[印] 卡倫斯 ( SandeepKaranth )。內容簡介 這本高階教程將通過大量示例幫助你精通Hadoop,掌握Hadoop實踐和技巧。主要內容包括:Hadoop MapReduce、Pig 和Hive 最佳化策略,YARN ...

本書分為18章,系統介紹Hadoop 生態系統大數據相關的知識,包括大數據概述、Cloudera Hadoop平台的安裝部署、HDFS分散式檔案系統、MapReduce計算框架、資源管理調度框架YARN 、Hive數據倉庫、數據遷移工具Sqoop、分散式資料庫HBase、ZooKeeper分散式...

2.2.2 Hadoop計算框架(MapReduce&YARN) 19 2.2.3 Hadoop數據倉庫(Hive) 20 2.2.4 Hadoop數據轉換與日誌處理(Sqoop&Flume) 20 2.2.5 Hadoop套用協調與工作流(ZooKeeper&Oozie) 20 2.2.6 大數據安全技術(Kerberos&LDAP...