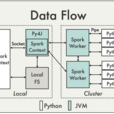

PySpark 是 Spark 為 Python 開發者提供的 API。

以下是 PySpark 提供的每個模組每個類的詳解及示例代碼。

基本介紹

- 外文名:PySpark

- 含義:Spark為 Python開發者提供的API

- 最新版本:2.1.0

- 對應的版本:0.10.4

子模組,PySpark 提供的類,pyspark.SparkConf,pyspark.SparkContext,pyspark.SparkFiles,pyspark.RDD,pyspark.Accumulator,pyspark.Broadcast,pyspark.Accumulator,

隨Spark 2.1.0發布的 Py4J位於 $SPARK_HOME/python/lib 目錄,對應的版本是 0.10.4。

子模組

pyspark.sql 模組

pyspark.streaming 模組

pyspark.ml 包

pyspark.mllib 包

PySpark 提供的類

pyspark.SparkConf

pyspark.SparkConf 類提供了對一個 Spark 應用程式配置的操作方法。用於將各種Spark參數設定為鍵值對。

pyspark.SparkContext

pyspark.SparkContext 類提供了套用與 Spark 互動的主入口點,表示套用與 Spark 集群的連線,基於這個連線,套用可以在該集群上創建 RDD 和 廣播變數 (pyspark.Broadcast)

pyspark.SparkFiles

SparkFiles 只包含類方法,開發者不應創建 SparkFiles 類的實例。

pyspark.RDD

這個類是為 PySpark 操作 RDD 提供了基礎方法。

first() 是 pyspark.RDD 類提供的方法,返回 RDD 的第一個元素。

aggregate() 方法使用給定的組合函式和中性“零值,先聚合每個分區的元素,然後再聚合所有分區的結果。

cache() 使用默認存儲級別(MEMORY_ONLY)對此 RDD 進行持久化。

collect() 返回一個列表,包含此 RDD 中所有元素。

pyspark.Accumulator

一種“只允許添加”的共享變數,Spark 任務只能向其添加值。

pyspark.Broadcast

Spark 提供了兩種共享變數:廣播變數 和 累加器,pyspark.Broadcast 類提供了對廣播變數的操作方法。

pyspark.Accumulator

pyspark.Accumulator 提供了對累加器變數的操作方法。

累加器是僅僅被相關操作累加的變數,因此可以在並行中被有效地支持。