項目背景

2024年2月,OpenAI推出開創性的文生視頻模型Sora,這代表視頻生成技術的重大飛躍。Sora能夠將簡短的文本描述轉換成詳細的、高清的視頻片段,且片段最長可達一分鐘。Sora推進了AI技術, 並在視頻製作中提供了新的創造潛能。

歷史沿革

2024年3月1日,Open Sora計畫正式在

GitHub公開。

技術特點

整體綜述

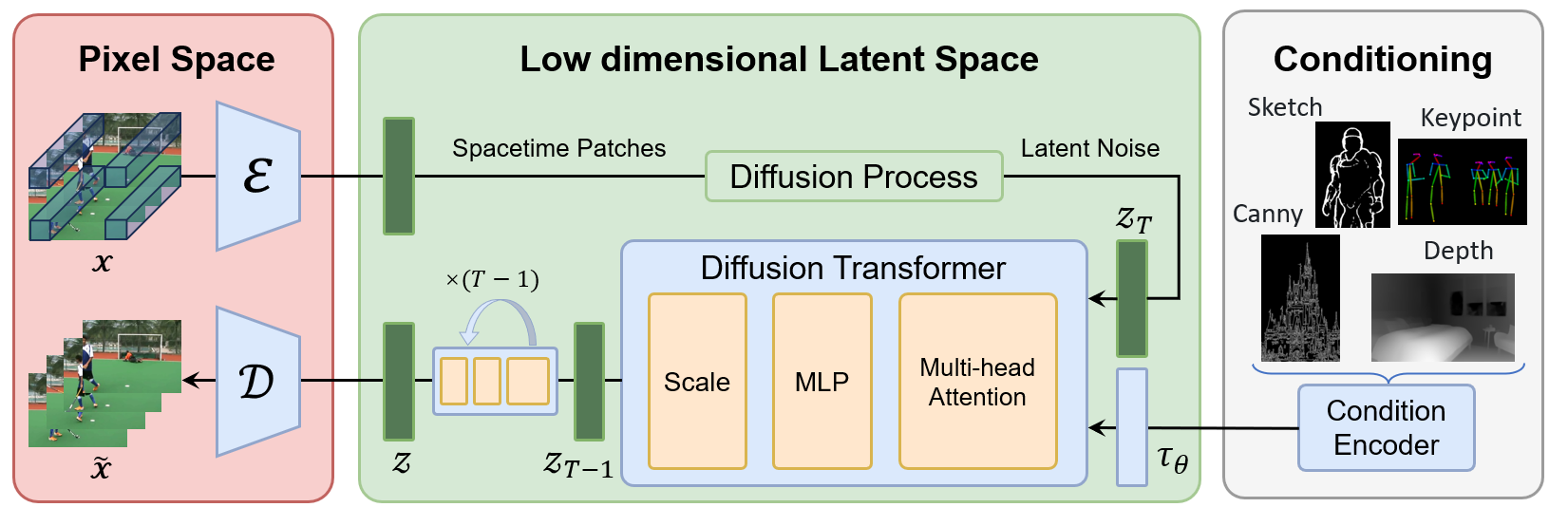

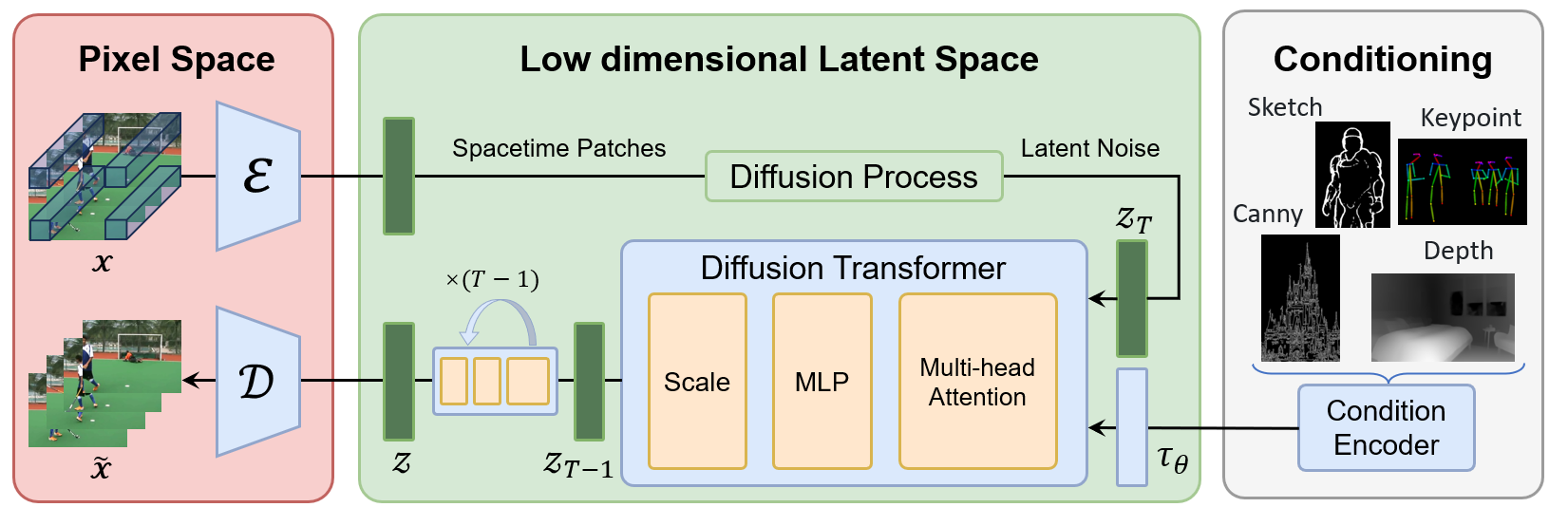

Open Sora團隊計畫復現Sora的技術架構主要由以下三部分組成:

Video VQ-VAE:用於視頻壓縮至潛在空間的模型,支持可變時長的處理。

Denoising Diffusion Transformer(去噪擴散型Transformer):核心的去噪和擴散模型,用於對批量潛變數進行去噪處理。

Condition Encoder(條件編碼器):用於添加額外條件信息,如類別、位置等,以指導生成過程。

Open Sora 的整體框架

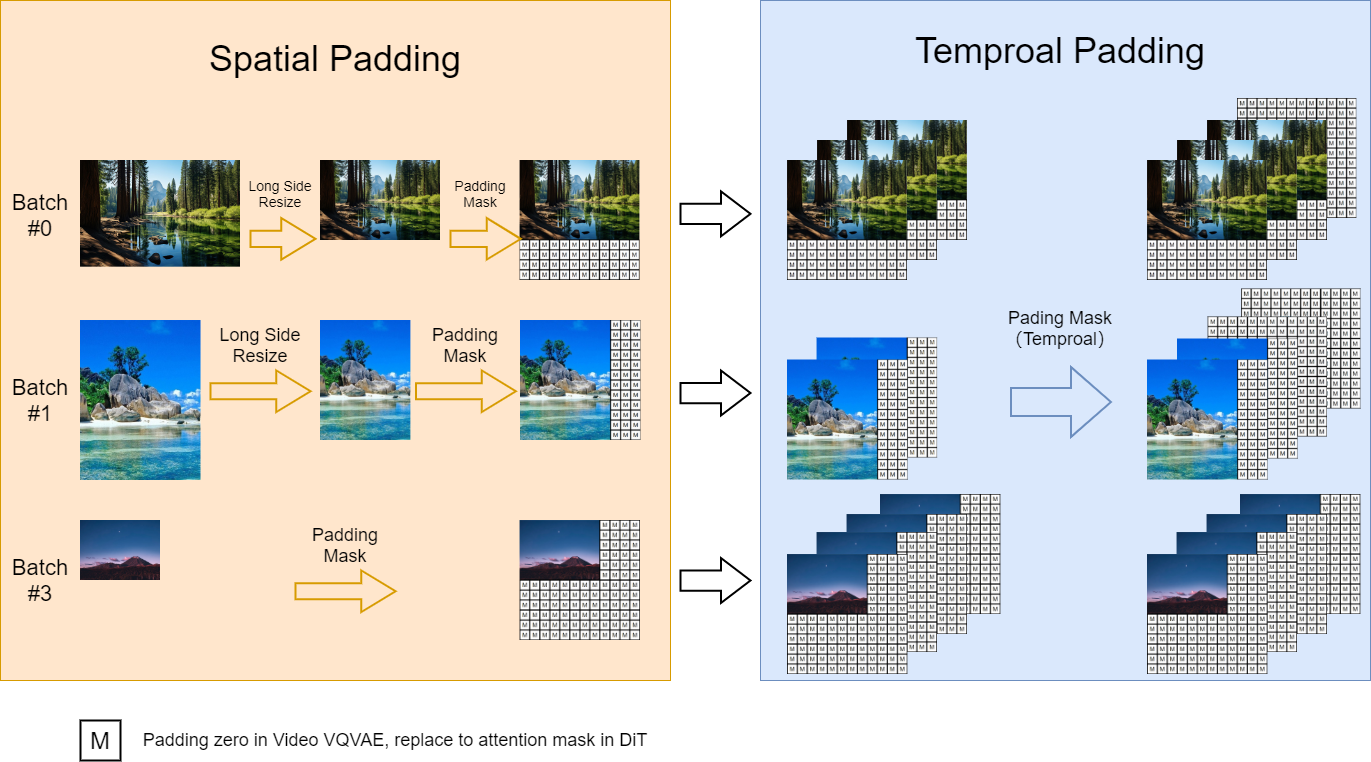

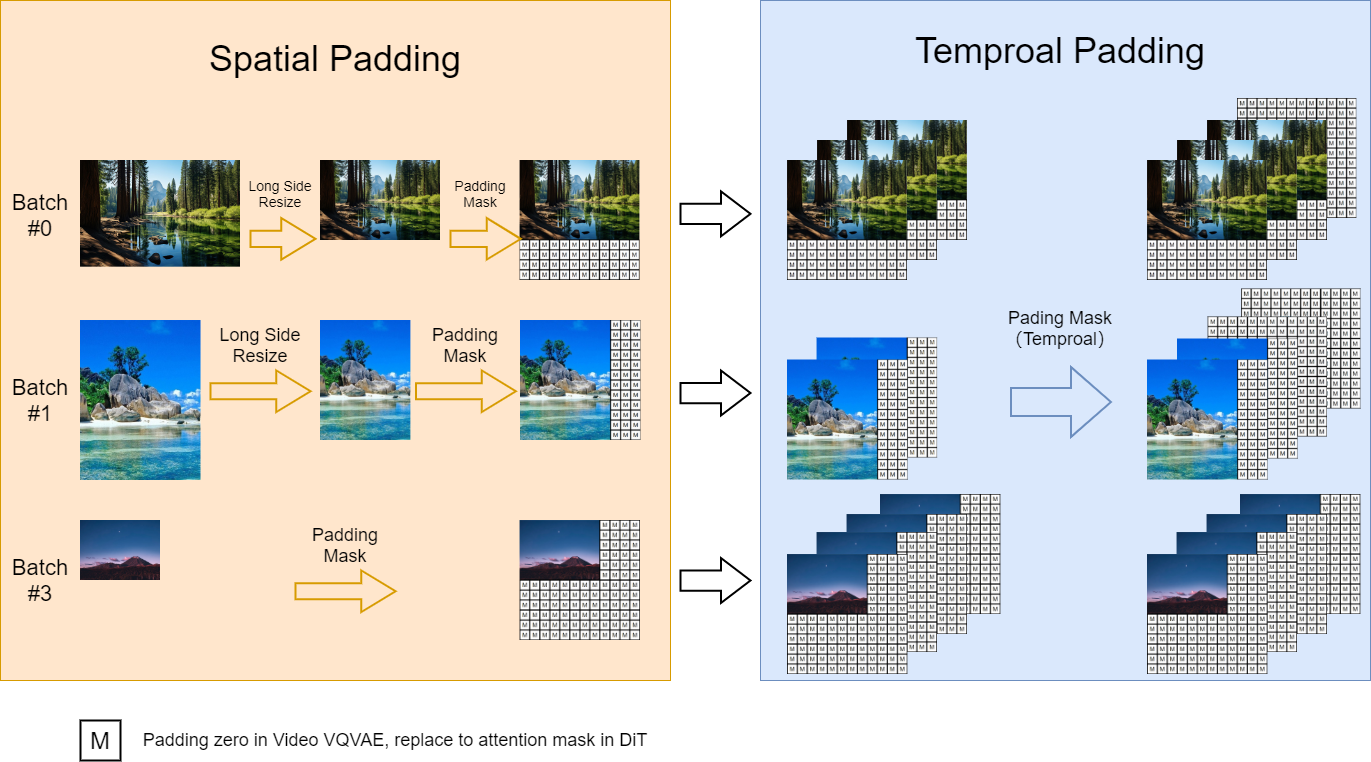

可變長寬比

為復現Sora視頻的可變長寬比,Open Sora團隊採用了一種動態掩碼策略。該策略參考了上海AI Lab提出的FiT

(Flexible Vision Transformer for Diffusion Model)方法,在並行批量訓練的同時保持靈活的長寬比。具體實施時,將高解析度視頻下採樣至最長邊為256像素,同時在右側和底部用零填充至一致的256x256解析度,便於模型的批量處理和注意力掩碼的套用。

Open Sora 的動態訓練策略

可變解析度

儘管模型在固定的256x256解析度上進行訓練,但在推理過程中,Open Sora團隊使用位置插值來實現可變解析度採樣。通過調整可變解析度噪聲潛變數的位置索引,使其與預訓練範圍對齊,從而使基於注意力的擴散模型能夠處理更高解析度的序列。

可變時長

利用VideoGPT中的Video VQ-VAE將視頻壓縮至潛在空間以支持可變時長的處理。同時,通過在擴展空間位置插值至時空維度,實現對可變時長視頻的處理能力。

實現功能

初步實現

Open Sora團隊已經初步實現了以下三個功能:可變長寬比處理、可變解析度處理和可變時長處理,並提供了相應的demo展示。此外,還完成了動態掩碼輸入和在embeddings上添加類條件等任務。

Open Sora 團隊的視頻重建結果

未來規劃

Open Sora團隊未來的工作重點包括完善採樣腳本、添加位置插值功能、在更高解析度上微調Video-VQVAE模型、合併SiT模型以及納入更多條件信息。同時,團隊計畫使用更多數據和GPU資源進行訓練以提升模型性能。

研發人員

參考資料:

社會影響

“Open Sora”項目一公開,“huxiuhan”等北京大學校友就積極回響,還有人表示可以提供高質量數據集。