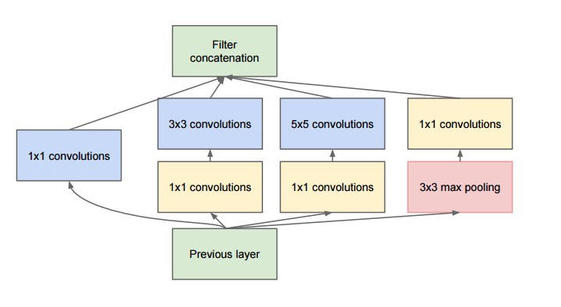

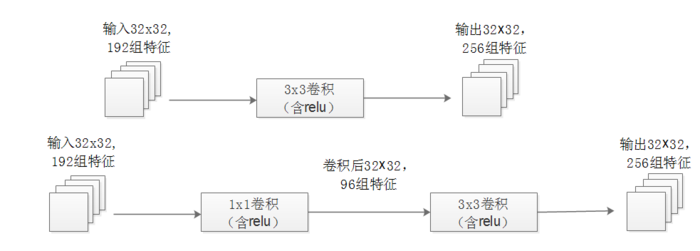

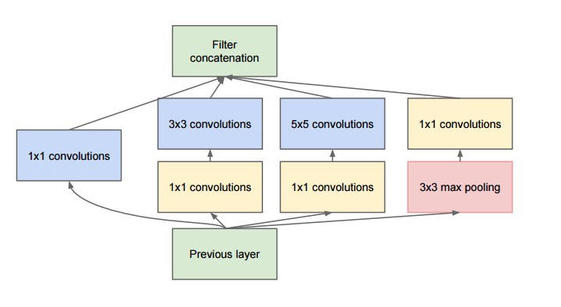

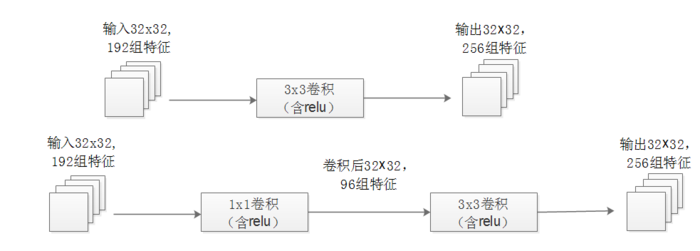

GoogLeNet是2014年Christian Szegedy提出的一種全新的深度學習結構,在這之前的AlexNet、VGG等結構都是通過增大網路的深度(層數)來獲得更好的訓練效果,但層數的增加會帶來很多負作用,比如overfit、梯度消失、梯度爆炸等。inception的提出則從另一種角度來提升訓練結果:能更高效的利用計算資源,在相同的計算量下能提取到更多的特徵,從而提升訓練結果。

基本介紹

- 外文名:GoogLeNet

- 類型:神經網路

GoogLeNet是2014年Christian Szegedy提出的一種全新的深度學習結構,在這之前的AlexNet、VGG等結構都是通過增大網路的深度(層數)來獲得更好的訓練效果,但層數的增加會帶來很多負作用,比如overfit、梯度消失、梯度爆炸等。inception的提出則從另一種角度來提升訓練結果:能更高效的利用計算資源,在相同的計算量下能提取到更多的特徵,從而提升訓練結果。

VGGNet和GoogleNet在2014ILSVRC分類大賽中取得了相似的突出成績。一個有意思的現象是在分類中表現突出的模型在很多領域都有廣泛套用。這意味著深度視覺結構的提升可以用於提升大部分依賴高質量視覺特徵的其它計算機視覺任務。同樣,網路質量的...

VGG模型是2014年ILSVRC競賽的第二名,第一名是GoogLeNet。但是VGG模型在多個遷移學習任務中的表現要優於googLeNet。而且,從圖像中提取CNN特徵,VGG模型是首選算法。它的缺點在於,參數量有140M之多,需要更大的存儲空間。但是這個模型很有...

6.3.3 GoogleNet v1 基於 TensorFlow2.0 的實現 294 6.4 ResNet:殘差網路獨領風騷 299 6.4.1 ResNet 模型結構 299 6.4.2 ResNet 基於 TensorFlow 2.0的實現 301 6.5 SENet:視覺注意力機制的起點 305 6.5.1 SENet ...

17.4.3GoogLeNet模型的一些注意事項 354 17.5本章小結 355 第18章暫時的冠軍——ResNet簡介及TensorFlow實現 356 18.1ResNet模型簡介 356 18.1.1ResNet模型定義 357 18.1.2定義工具的TensorFlow實現 359 18.1.3ResNet模型的...

6.4.3GoogLeNet模型結構解析139 6.4.4GoogLeNet模型的特點141 6.5ResNet142 6.5.1ResNet模型的研究動機142 6.5.2ResNet模型的結構143 6.6DenseNet145 6.7本章小結149 習題 6150 第7章智慧型圖像處理151 7.1數字圖像處理概述151...

AlexNet是2012年ImageNet競賽冠軍獲得者Hinton和他的學生Alex Krizhevsky設計的。也是在那年之後,更多的更深的神經網路被提出,比如優秀的vgg,GoogLeNet。 這對於傳統的機器學習分類算法而言,已經相當的出色。模型簡介 AlexNet中包含了幾個...

7.6透徹理解GoogLeNet全景架構 7.7ResNet關鍵結構恆等映射背後的思想及原理 7.8全面理解ResNet全景架構 第8章循環神經網路 8.1為什麼要用遞歸神經網路 8.1.1為什麼需要遞歸神經網路 8.1.2RNN結構以及套用 8.2RNN計算圖 8.3RNN前...

61 GoogLeNet概述118 62 GoogLeNet實現MNIST分類119 621 基於Keras搭建GoogLeNet網路結構119 622 對GoogLeNet進行訓練、評估與預測125 63 ResNet概述129 64 ResNet50實現MNIST分類131 641 基於Keras搭建ResNet50網路結構131 642 對Res...

5.5 GoogLeNet 57 5.5.1 Inception結構 57 5.5.2 GoogLeNet結構——基於Inception V1模組 59 5.5.3 GoogLeNet特點 62 5.6 ResNet 62 5.6.1 ResNet殘差塊結構 63 5.6.2 ResNet結構 63 5.6.3 ResNet特點 66 ...

通過LeNet 網路模型的Mnist 手寫實例介紹其樣本訓練和識別過程,進一步詳細解讀了AlexNet、VGGNet、GoogLeNet、Siamese 和SqueezeNet 網路模型,並給出了這些模型基於Caffe 的訓練實戰方法。然後,本書解讀了利用深度學習進行目標定位的經典網路...