基本介紹

- 中文名:數據最佳化

- 外文名:Data optimization

- 最佳化流程:數據採集、數據分析和數據處理

- 最佳化模型:SQL最佳化模型、快取最佳化模型等

- 簡稱:EVDO

- 套用學科:計算機科學、通信工程、機械科學

基本介紹

最佳化模型

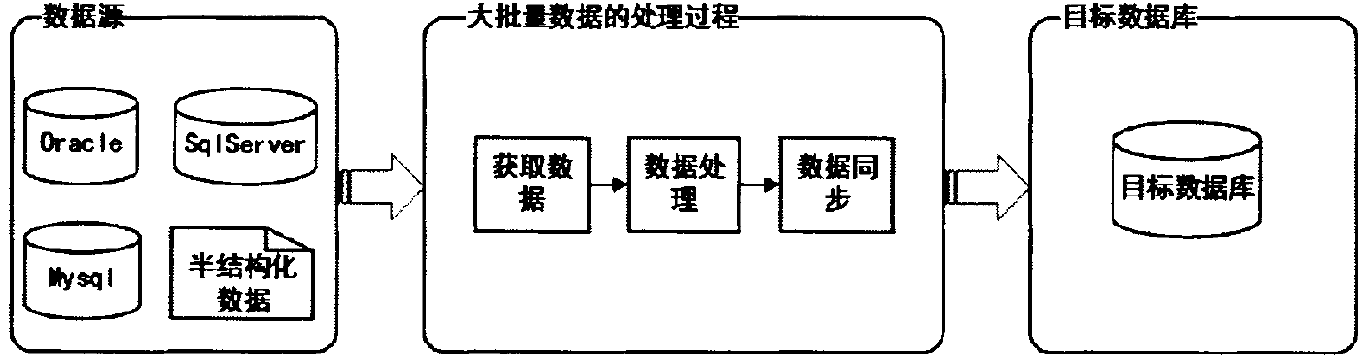

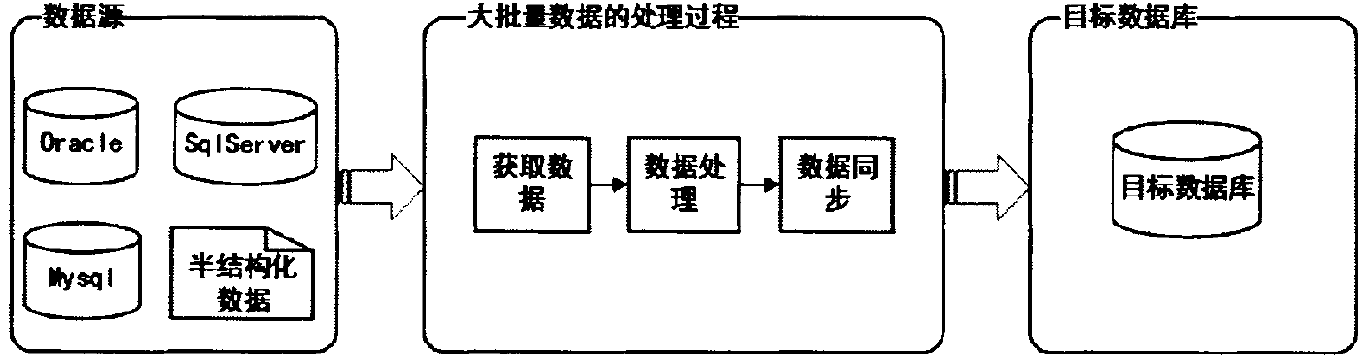

最佳化流程

批量處理框架

研究背景

過程介紹

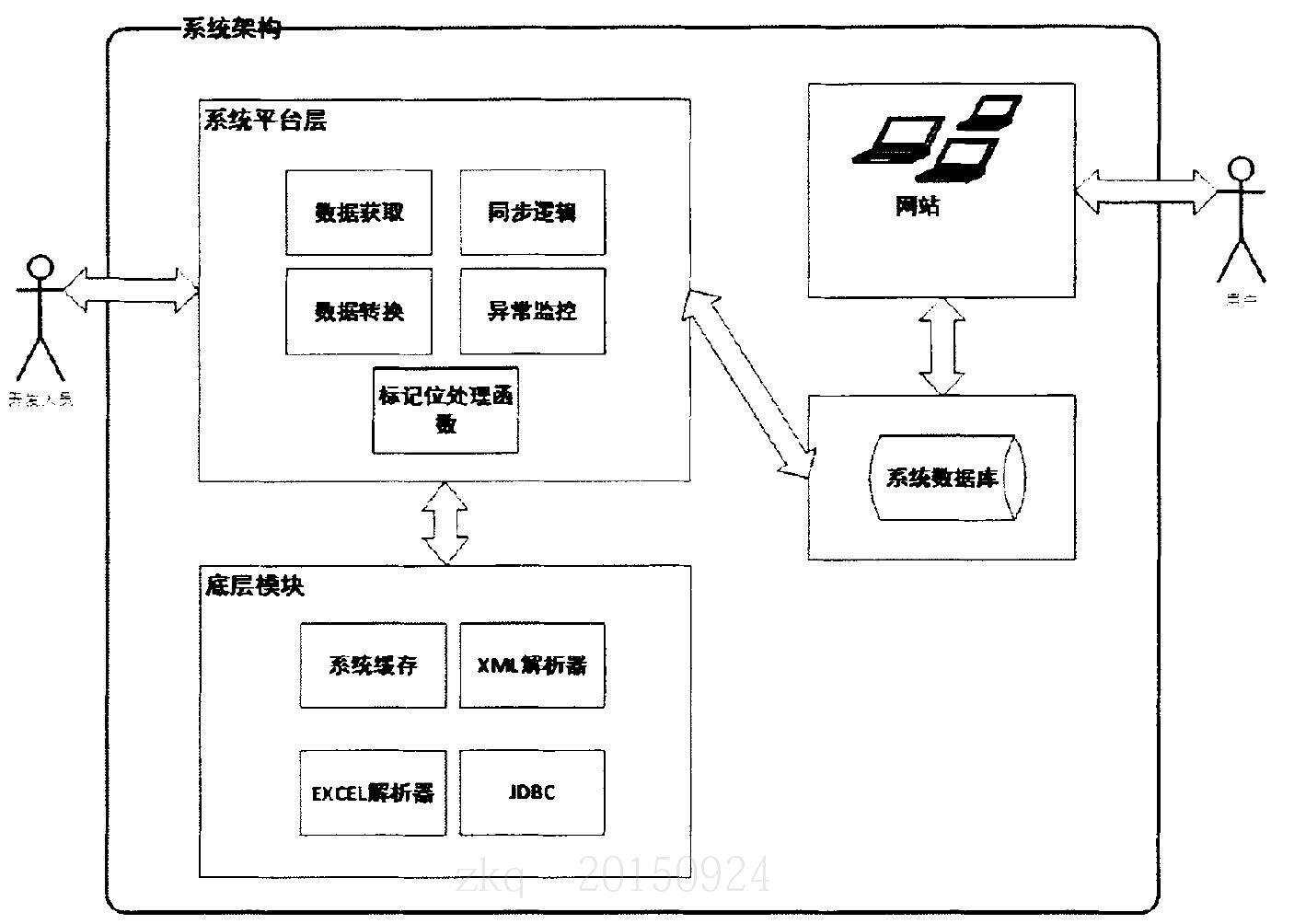

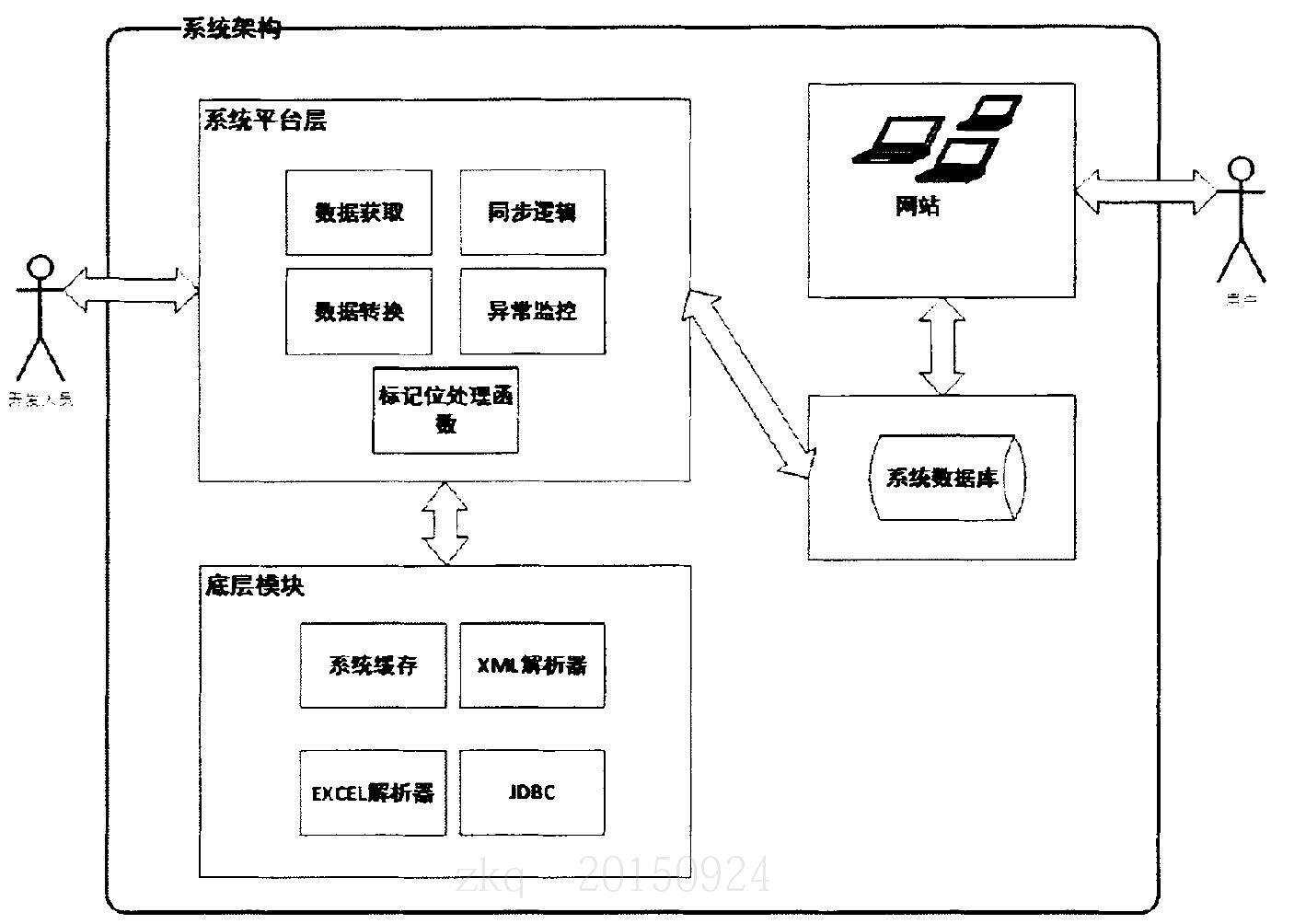

系統架構

資料庫是支持知識發現的基礎工程。要獲得高信息含量的、有用的知識,理想情況是原始數據是不含噪聲的正確數據。數據是組成資料庫的基本單元,構建高質量的資料庫,必須對原始數據進行數據預處理,也就是所說的數據最佳化(EVDO)。基本...

最佳化概述 讓系統運行得快最重要因素是數據庫的基本設計。並且還必須清楚系統要用來做什麼,以及存在的瓶頸。最常見的系統瓶頸有以下幾種:磁碟搜尋 它慢慢地在磁碟中搜尋數據塊。對現代磁碟來說,平時的搜尋時間基本上小於10毫秒,因此理論...

《Oracle資料庫性能最佳化實踐指南》是2015年電子工業出版社出版的圖書,作者是霜月琴寒。內容簡介 《Oracle資料庫性能最佳化實踐指南》涉及了Oracle最佳化的所有方面,系統地講述了Oracle最佳化的相關內容。《Oracle資料庫性能最佳化實踐指南》分為5個...

《Oracle資料庫性能最佳化實務》是機械工業出版社出版的視頻教程,作者是白鱔。課程簡介 隨著Oracle資料庫在國內的普及以及Oracle資料庫套用的發展。數據日益集中,數據量也隨之以幾何級數增長,資料庫從業人員也大幅度增加。Oracle資料庫性能最佳化...

《數據庫高效最佳化》是2020年機械工業出版社出版的圖書,作者是馬立和,高振嬌,韓鋒。本書以大量案例為依託,系統講解了SQL語句最佳化的原理、方法及技術要點,尤為注重實踐,在章節中引入了大量的案例,便於學習者實踐、測試,反覆揣摩。本...

數據庫性能最佳化(database performance tuning)是2018年公布的計算機科學技術名詞。定義 通過自定義地設定、調整資料庫配置和資料庫管理系統(DBMS)參數等方式,最大限度地利用系統資源,提高資料庫系統性能和工作效率。出處 《計算機科學技術...

《Oracle數據庫性能最佳化的藝術》內容高屋建瓴,用辯證法中的系統化分析方法,不僅從硬體(伺服器系統、存儲系統、網路系統等)、軟體(作業系統、中間件系統、套用軟體等)和套用場景(用戶訪問模式、用戶使用頻度、數據承載壓力等)等多個...

《大數據最佳化建模與算法》是2021年西安電子科技大學出版社出版的圖書。內容簡介 大數據最佳化建模及求解最佳化模型的算法設計是解決大數據問題的關鍵技術。本書選擇信息學科領域一些典型的大數據問題,介紹這些問題的最佳化建模方法,並對這些最佳化模型...

《面向快閃記憶體特性的檔案系統數據組織最佳化技術》是依託清華大學,由陸游游擔任項目負責人的青年科學基金項目。項目摘要 快閃記憶體存儲設備正越來越廣泛地被套用實際系統。快閃記憶體的數據操作與傳統磁碟的操作存在較大差異,如快閃記憶體具有擦除操作、隨機讀取...

《Oracle數據庫性能最佳化》是2005年人民郵電出版社出版的圖書,作者是蓋國強。本書給出了大量取自實際工作現場的實例。在分析實例的過程中,兼顧深度與廣度,不僅對實際問題的現象、產生原因和相關的原理進行了深入淺出的講解,更主要的是,...

《數據定價策略與最佳化研究》是2024年經濟科學出版社出版的圖書。內容簡介 本專著是基於作者近期主持的國家社科基金項目(項目名稱:考慮消費者購買行為的數據產品設計、定價與更新策略研究,項目編號:20BGL107)和教育部人文社科規劃項目(...

“案例篇”從硬體和系統、MySQL架構等方面給出了性能最佳化的十幾個案例,包括:性能測試的基本最佳化思路和最需要關注的性能指標解釋、對日常SQL語句執行慢的基本定位、避免x86可用性的一般性方法、節能模式會怎樣影響性能、I/O存儲作為數據庫...

李海翔,網名“那海藍藍”,資深數據庫專家,從事資料庫研發、資料庫測試與技術管理等工作10餘年,對資料庫的核心有深入的研究,長於PostgreSQL和MySQL等開源資料庫的核心與架構。現任職於Oracle公司MySQL全球開發團隊,從事查詢最佳化技術的...

《數據庫索引設計與最佳化》是2015年出版的圖書,作者是Tapio Lahdenmaki、Michael Leach。內容簡介 本書提供了一種簡單、高效、通用的關係型資料庫索引設計方法。作者通過系統的講解及大量的案例清晰地闡釋了關係型資料庫的訪問路徑選擇原理...

《Oracle Database 11g性能最佳化攻略》是人民郵電出版社出版的圖書,作者是[美] Sam R. Alapati、[美] Darl Kuhn、[美] Bill Padfield。內容簡介 三位經驗豐富的頂級Oracle DBA再次聯手,為讀者呈現這本Oracle數據庫性能最佳化攻略。《...

該課程講述了數據庫是大多數系統進行數據存儲的基礎組件,資料庫的效率對系統的穩定和效率有著至關重要的影響等內容。課程大綱 第1章 資料庫最佳化簡介 本章介紹本門課程的課程目標,從整體上把握資料庫最佳化的相關內容。1-1 MySQL最佳化簡介...

《分散式數據挖掘最佳化技術》是依託西安電子科技大學,由劉志鏡擔任項目負責人的面上項目。中文摘要 本項目的研究內容包括:(1)研究適用於分散式數據挖掘套用的分散式格線處理體系結構dmGRID,並分析dmGRID與目前套用的其他分散式格線體系結構的...

本書系統性地總結了DB2數據庫性能調整的方法、流程、思路和保持系統良好性能的注意要點。最難得的是作者分享了10年積累的DB2性能調優案例和經驗總結。編輯推薦 《DB2資料庫性能調整和最佳化》特色:從全局的角度(作業系統、存儲、資料庫設計...

最佳化技術是指通過一定的方法或策略使系統或程式有關性能提高。最佳化技術的好處主要可以從以下幾個方面來體現:記憶體利用更加合理;運行時間更短;讀取數據的數據更快;準確率更高等。不管是從軟體角度還硬體角度進行最佳化工作,最佳化技術的基礎是...

第6章 最佳化數據存儲 第7章 最佳化表空間 第8章 調整UNDO段 第4部分 高級調整 第9章 檢測鎖爭用 第10章 其他調整問題 第11章 高級調整主題 第5部分 調整記憶體 第12章 調整工具 第6部分 套用調整 第13章 SQL調整 第14章 最佳化...

《幾類數值最佳化方法》是Scientific Research Publishing出版的圖書,作者是Gonglin Yuan,Liqun Qi,Xiwen Lu,Zengxin Wei 內容簡介 本書是作者的博士畢業論文,共分為七章,前四章是關於無約束最佳化方面的方法,第五章和第六章是非線性...

《大規模數據存儲系統能耗最佳化方法的研究》是依託華中科技大學,由謝長生擔任項目負責人的重點項目。項目摘要 數據存儲系統的規模不斷擴大導致系統能耗以及相關運行維護費用大幅提高,如何在確保套用獲得連續快捷的數據服務的同時,降低系統運行...

《DB2數據庫性能調整和最佳化(第3版)》是2017年清華大學出版社出版的圖書,作者是牛新莊。內容簡介 本書側重於介紹DB2資料庫的性能調優。性能調優是一個系統工程:全面監控分析作業系統、I/O性能、記憶體、套用及資料庫才能快速找到問題根源...

《空間眾包數據處理及其最佳化關鍵技術研究》是依託北京航空航天大學,由童詠昕擔任項目負責人的青年科學基金項目。項目摘要 隨著Web 2.0技術的興起,眾包為傳統數據管理挑戰提供了一種通過匯聚群體智慧求解問題的新型數據處理模式,使得眾包數據...

《基於動態邊界約束的截面數據最佳化重構研究》是2019年電子工業出版社出版的圖書,作者是張旭。作譯者:張旭 出版時間:2019-09千 字 數:148版次:01-01頁 數:124 開本:16開裝幀:I S B N :9787121353543 內容介紹 在逆向工程中...

參數最佳化是達到設計目標的一種方法,通過將設計目標參數化,採用最佳化方法,不斷的調整設計變數,使得設計結果不斷接近參數化的目標值。參數最佳化概念 模型參數最佳化是通過極小化目標函式使得模型輸出和實際觀測數據之間達到最佳的擬合程度,由於...

《複雜生產過程基於數據的最佳化調度理論與方法》是依託同濟大學,由吳啟迪擔任項目負責人的重點項目。中文摘要 有效地利用企業自動化系統中的大量離線上數據,在難於建立機理模型的條件下,更好地解決實際複雜生產過程調度問題已成為國民經濟和...

最小二乘法(又稱最小平方法)是一種數學最佳化技術。它通過最小化誤差的平方和尋找數據的最佳函式匹配。利用最小二乘法可以簡便地求得未知的數據,並使得這些求得的數據與實際數據之間誤差的平方和為最小。最小二乘法還可用於曲線擬合...