定義

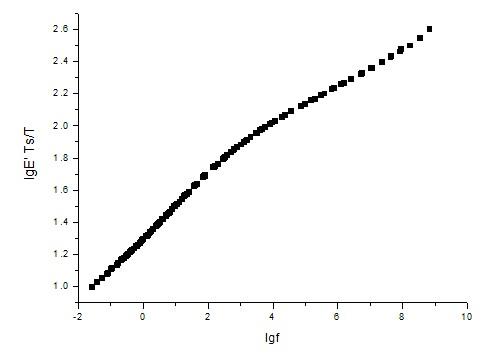

假設隨機向量 的機率密度為 ,通過Y數據分布中間的一條曲線 ,如果滿足 ,則稱 是Y的一條主曲線其中 是數據點y投影到曲線 上s點的值。

由主曲線定義可知:主曲線上每個點是所有投影至該點的數據點的條件均值,它滿足自相合性。主曲線的理論基礎是尋找嵌入高維空間的非歐氏低維流形,也是線性主成分的非線性推廣,它能真實地反映數據的形態。

算法研究

本程式定義了主曲線和確定主曲線的實際算法。多邊形線算法的基本運算法則是首先確定一條直線段,然後在循環算法中通過不斷加入新的頂點來增加線段的數量。在加入一個新的頂點以後,所有的頂點位置在一個內部的環中被更新。在這個例子中,PL運算法則和HS運算法則在計算的複雜程度和算法的完善程度上作出了比較。4段和15段,由在半圓上任意兩個坐標點加入單獨的高斯誤差而產生。

PL算法在由NIST19號專有資料庫產生的單獨數據元構成的圖像中得到了測試。我們發現PL算法可以有效的找出沒有環和分叉的圖像的中間軸。由於中間軸可能是一些曲線連線而成而不是只有一條曲線,所以在這裡我們擴展了PL算法,找出數據元的主曲線。擴展了的算法也包含了實現分段線性骨架的兩個原則,一種獲取字元圖像近似輪廓的初始化方法和一系列用來改善由初始化方法獲得的骨架結構質量的更改結構工作。為了避免混淆,我們用術語“骨架”來表示近似性中間軸的二元圖像,我們把由PL算法產生出的連線曲線看做模板骨架.

套用

主曲線以前被用在圖像處理領域。這種圖像用來描述在衛星拍攝下的冰川及其輪廓。其主程式用了一個閉合的曲線來估算冰川的輪廓。專家們除去了HS算法中不合適的部分,並且用更完善的粗略估算冰川輪廓的程式來取代HS算法的初始化步驟。此外,採用數據元集合,而不是HS算法所產生的點或線的集合,向中間軸集中的方式來擴展現有的聚合算法。初始化的曲線由SOM算法的一個變數產生,在

SOM算法中相互關係被定義為字元圖像的一個最小二叉樹。HS算法用來使曲線與模板相對應。下一步的要點與SOM算法的更新規則類似。

利用主曲線實現分段線性骨架的方法被Mahmoud、Datta和Parui等人所提出。同樣的方法,在SOM算法中用來最最佳化分段線性骨架的頂點位置。算法在構建骨架方面採用“自頂向下”的策略:近似性地從一個線性拓撲出發,然後逐步加入環和交叉到骨架中,骨架是由基於SOM算法的當前幾何樣式得出的。SOM算法涉及到一個獲取字元圖像分段線性骨架的運算法則。這種運算法則以ISODATA算法為基礎,ISODATA算法近似於SOM算法。

目的

主曲線算法的目的是找出與字元圖像相對應的光滑的分段線性曲線。這些曲線在某個頂點彼此連線,因而在字元圖像的中心平面範圍內形成一個歐幾里德曲線。一個歐幾里德曲線G(V,S)在空間中由變數V和S確定,

主曲線算法從一個基於傳統稀釋方法的初始化工作開始。初始曲線找出字元圖像的近似拓撲結構,然而,它不是平滑的,而且它通常包含許多假的分叉和不適合的結構元素。為了解決這兩個問題,在前兩步中間增加了更改結構的步驟,使得主曲線算法更加有效。在更改結構步驟中,我們運用一些操作手段來調整曲線骨架結構的不完整的地方。算法建立在最小能量函式的基礎之上。

研究動機與意義

自1904年Spearman提出線性主成分分析方法以來,由於這種方法簡單且便於使用,至今還是數據統計分析的重要工具之一。線性主成分分析的原理是將數據集合投影到一個矢量,使得投影的均方差最大,由此,將這個矢量稱為數據集合的第一主成分。正是這個考慮,在均方差的意義下,這個方法有兩個重要的優點:其一,數據集合可以使用一個矢量來描述,從而達到減小信息描述長度的目的,其二,計算第一以及依次主成分,可以變換為求解基於數據自相關矩陣的特徵值方程。另外,第一與依次主成分矢量保持正交關係,這意味著,與主成分矢量平行的矢量具有與主成分相同的性質。正是這兩個原因,加上在統計上以均方差為保證,主成分分析得到廣泛的套用。 由於信息描述長度與信息保持性之間存在矛盾,相對較長的信息描述長度,較短描述長度的信息描述是以損失信息保持性為代價的,而主成分分析的本質是一種在均方差意義下的統計平均。儘管它可以獲得較短的信息描述長度,但是,信息保持性的代價相當大,由於信息保持性是對數據分布的規律性認識,因此,對某些問題,這個代價可接受的,但是,另外一些問題,可能就不能接受了。例如,對原始語音信號的分析,單純的主成分分析就不一定有效。 顯然,這沒有一個一般性的答案,這取決於所需解決問題的需求。

目前,儘管在主曲線的研究中,還存在著大量的數學問題,但是,由於其暗示的廣泛套用前景,已引起計算機科學家的關注,現在套用方面已有大量的報導,如線性對撞機中對電子束運行軌跡的控制、圖像處理中辨識冰原輪廓、手寫體的主曲線模板化、語音識別中對聲音數據的約簡建模和數據可聽化、生態學中尋找種群的有序分布及過程監控。同時,在認知領域Seung提出感知以流形方式存在,並在神經生理學上發現整個神經細胞群的觸發率可以由少量的變數組成的函式來描述,如眼的角度和頭的方向,這隱含了神經元群體活動性是由其內在的低維結構所控制。主曲線本身是流形的一維形式。

原理、發展脈絡以及套用

為了說明主曲線的原理、發展脈絡以及套用,首先介紹其原始動機是必要的。Hastie在他關於主曲線的開創性論文中描述了其研究動機,Hastie認為主曲線與非線性回歸方法的發展上具有對稱性,分別是線性主成分分析與線性回歸分析的非線性推廣模型,Hastie寫到:類似於線性回歸方法的非線性推廣,使用光滑曲線代替線性主成分總結數據,以求出對稱變數之間的曲線,這樣的曲線從數據的中部光滑地通過,且不限制於對數據的光滑線性平均,甚至不限制於數據的中部是直線,只希望使得數據點集合到曲線的正交距離最小。這個陳述清晰地指出了他的研究與主成分分析和回歸分析的區別,並給出了建模的統計目標。同時,從這個陳述中也可以看出,基於直線的主成分分析只是主曲線的一個特例。因此,主曲線的提出,可以理解為基於線性的主成分分析方法向更精確描述實際世界的非線性分析方法的推廣。 應該指出的是,目前,“向非線性”推廣是數據統計分析的研究主流,但是,存在著不同的技術路線。

分類

最典型的研究大致可以分為兩類:

其一,根據統計學習理論中的核技術,將數據集合映射到特徵空間,然後,在特徵空間計算數據集合的主成分,稱為核主成分分析(KPCA),這個技術路線的本質還是線性主成分分析。

其二,從數據本身的分布出發,希望找到能最好描述數據內在結構的機率分布模型,如生成式拓撲映射(Generative Topographic Mapping,縮寫為GTM),矢量量化(VQ)及主曲線,以及流形擬合等。提出“主曲線的研究與回歸分析有何區別”是自然的,兩者的動機都是企望求出一個函式代替數據集合,但是,兩者有本質的差別:其一,一般地說,回歸分析是假設數據集合的變數有因果關係,換句話說,數據的變數可以表示為一個因果關係的函式,有些是自變數,有些則是因變數。其二,回歸分析一般需要給定一個數學基函式,回歸分析是根據數據集合中變數的因果關係,計算這個數學基函式待定的參數。這與主曲線的研究動機完全不同。對於前者,主曲線的研究目標是解決數據變數沒有必然因果關係的問題,更重要的是後者,認為事先假定數據服從某種分布(如常態分配)的方法(這與給定數學基函式,根據數據確定參數的方法類似),對某些未知世界的解釋是不合理的,因為這個假設可能是錯誤的,為了保證數據分析不是假設在一個錯誤結構下,主曲線的研究強調非參數分析。

當然,這並不是完全否定了參數法這一經典方法,事實上,參數法在先驗知識明確時存在相當大的好處。總之,根據上述討論的動機,主曲線是尋找一種幾何上直觀、理論上完備、就解決的問題而言,這個方法與主成分分析一致,但是,主曲線的目標不是僅僅尋找一個數據集合的脊梁骨,而是希望獲得數據集合的骨架。數據集合的脊梁骨可以使用線性的方法解決,但骨架就需要藉助非線性方法了。應該強調的是,主曲線繼承了主成分分析的眾多思想,它是主成分分析的非線性推廣。另外,儘管這個方法似乎與回歸分析的目標類似,都是試圖獲得對數據集合信息長度更短的表示,但是,這個方法與回歸分析完全不同,最大的差別是它不是事先給定一個基函式(或假定一個分布),從而將問題變換為參數估計問題,而是一種非參數的方法。